बड़े भाषा मॉडल

बड़े भाषा मॉडल ( एलएलएम ) एक कम्प्यूटरीकृत भाषा मॉडल है, जो एक कृत्रिम तंत्रिका नेटवर्क द्वारा भारी मात्रा में "पैरामीटर" (इसकी परतों में "न्यूरॉन्स" और उनके बीच लाखों से अरबों "वजन") का उपयोग करके बनाया गया है, जो कि स्व-पर्यवेक्षित का उपयोग करके विकिपीडिया कॉर्पस और कॉमन क्रॉल जैसे निगमों द्वारा प्रदान किए गए खरबों टोकन (शब्दों के हिस्से) वाले बड़ी मात्रा में गैर-लेबल वाले पाठों की बड़े पैमाने पर समानांतर प्रसंस्करण के कारण अपेक्षाकृत कम समय में कई जीपीयू पर (पूर्व) प्रशिक्षित किया जाता है। सीखना या अर्ध-पर्यवेक्षित शिक्षण, [1] जिसके परिणामस्वरूप संभाव्यता वितरण के साथ एक टोकनयुक्त शब्दावली होती है। एलएलएम को अतिरिक्त जीपीयू का उपयोग करके उन्नत किया जा सकता है ताकि मॉडल को बिना लेबल वाले पाठों की विशाल मात्रा पर और भी अधिक मापदंडों के साथ प्रशिक्षित किया जा सके। [2]

ट्रांसफार्मर एल्गोरिथ्म का आविष्कार, या तो यूनिडायरेक्शनल (जैसे कि जीपीटी मॉडल द्वारा उपयोग किया जाता है) या द्विदिशात्मक (जैसे कि बीईआरटी मॉडल द्वारा उपयोग किया जाता है), ऐसे बड़े पैमाने पर समानांतर प्रसंस्करण की अनुमति देता है। [3] उपरोक्त सभी के कारण, विशिष्ट कार्यों के लिए अधिकांश पुराने (विशेष) पर्यवेक्षित मॉडल पुराने हो गए। [4]

एक अंतर्निहित तरीके से, एलएलएम ने मानव भाषा निगम में निहित वाक्यविन्यास, शब्दार्थ और "ऑन्टोलॉजी" के बारे में एक सन्निहित ज्ञान प्राप्त किया है, लेकिन निगम में मौजूद अशुद्धियों और पूर्वाग्रहों के बारे में भी। [4]

उल्लेखनीय उदाहरणों में ओपन एआई के जीपीटी मॉडल (उदाहरण के लिए, जीपीटी-3.5 और जीपीटी-4, चैटजीपीटी में प्रयुक्त), गूगल का फिल्म (बार्ड में प्रयुक्त), और मेटा का ल्लामा, साथ ही ब्लूम, एर्नी 3.0 टाइटन और क्लॉड शामिल हैं।

इतिहास[संपादित करें]

पूर्ववर्ती[संपादित करें]

एलएलएम का मूल विचार, जो कि यादृच्छिक भार के साथ ब्लैक बॉक्स के रूप में एक तंत्रिका नेटवर्क के साथ शुरू करना है, एक सरल दोहराव वास्तुकला का उपयोग करना और इसे एक बड़े भाषा कोष पर (पूर्व) प्रशिक्षित करना, 2010 तक संभव नहीं था जब जीपीयू का उपयोग किया गया था बड़े पैमाने पर समानांतर प्रसंस्करण को सक्षम किया, जिसने धीरे-धीरे तार्किक एआई दृष्टिकोण को बदल दिया है जो प्रतीकात्मक कार्यक्रमों पर निर्भर है। [5] [6] [7]

एलएलएम के अग्रदूतों में एल्मन नेटवर्क शामिल था, [8] जिसमें एक आवर्ती नेटवर्क को "कुत्ता आदमी का पीछा करता है" जैसे सरल वाक्यों पर प्रशिक्षित किया गया था। फिर, प्रत्येक शब्द को एक वेक्टर (इसका 'आंतरिक प्रतिनिधित्व') में बदलने के लिए (पूर्व-)प्रशिक्षित मॉडल का उपयोग किया गया था। इन वैक्टरों को एक पेड़ के रूप में निकटता से एकत्रित किया गया था। तब पेड़ में एक संरचना पाई गई। क्रिया और संज्ञा प्रत्येक एक बड़े समूह से संबंधित थे। संज्ञा समूह के भीतर, दो समूह होते हैं: निर्जीव और चेतन। और इसी तरह।

1950 के दशक में, बड़े पैमाने पर समानांतर प्रसंस्करण को सक्षम करने वाले आधुनिक जीपीयू के बिना, एक सरल दोहरावदार वास्तुकला द्वारा प्राकृतिक भाषा सीखने का विचार सिर्फ एक विचार बनकर रह गया। [9] [10] बाद में 1990 के दशक में, सांख्यिकीय मशीन अनुवाद के लिए आईबीएम संरेखण मॉडल [11] ने एलएलएम की भविष्य की सफलता की घोषणा की। [12] एक प्रारंभिक कार्य जो 2001 में शब्दों के स्पष्टीकरण (जैसे कि "तब" और "से" में अंतर करना) के लिए इंटरनेट से निकाले गए संग्रह का उपयोग करता है। इसमें 1 अरब शब्द के कोष का उपयोग किया गया था, जिसे उस समय बहुत बड़ा माना जाता था। [13]

ट्रांसफार्मर ढांचे के लिए लीड-अप[संपादित करें]

ट्रांसफॉर्मर (Transformer) कृत्रिम बुद्धिमत्ता में प्रयुक्त होने वाला एक मशीन लर्निंग मॉडल है। यह प्राकृतिक भाषा संसाधन के लिए विशेष रूप से डिज़ाइन किया गया है। शुरुआती "बड़े" भाषा मॉडल दीर्घकालिक अल्पकालिक मेमोरी (एलएसटीएम) (1997) जैसे आवर्ती आर्किटेक्चर के साथ बनाए गए थे। एलेक्सनेट (2012) द्वारा छवि पहचान के लिए बड़े तंत्रिका नेटवर्क की प्रभावशीलता का प्रदर्शन करने के बाद, शोधकर्ताओं ने अन्य कार्यों के लिए बड़े तंत्रिका नेटवर्क को लागू किया। 2014 में, दो मुख्य तकनीकें प्रस्तावित की गईं।

- Seq2seq मॉडल (380 मिलियन पैरामीटर) ने मशीनी अनुवाद करने के लिए दो LSTM का उपयोग किया, [14] और उसी दृष्टिकोण का उपयोग [15] (130 मिलियन पैरामीटर) में किया गया था लेकिन एक सरलीकृत वास्तुकला ( जीआरयू ) के साथ।

- ध्यान तंत्र को 2014 के पेपर में बहदानौ एट द्वारा प्रस्तावित किया गया था। अल., [16] जहां दो LSTM के बीच में एक "ध्यान तंत्र" जोड़कर एक seq2seq मॉडल में सुधार किया गया था। यह "एडिटिव अटेंशन" है, जो ट्रांसफॉर्मर की तरह समान अटेंशन मैकेनिज्म (स्केल्ड "डॉट प्रोडक्ट अटेंशन") नहीं है, लेकिन यह एक समान कार्य पूरा करता है। [17]

2016 में, गूगल अनुवाद ने अपनी तकनीक को सांख्यिकीय मशीन अनुवाद से तंत्रिका मशीन अनुवाद में बदल दिया। यह LSTM और ध्यान के साथ एक seq2seq था। 10 वर्षों में निर्मित पिछली प्रणाली की तुलना में प्रदर्शन के उच्च स्तर तक पहुँचने में उन्हें 9 महीने लगे। [18] [19]

2017 का पेपर "आपको केवल ध्यान देने की आवश्यकता है" [17] बहदानौ एट द्वारा 2014 के पेपर से ध्यान तंत्र को अलग कर दिया। अल., [16] और ध्यान तंत्र के चारों ओर ट्रांसफार्मर वास्तुकला का निर्माण किया। जबकि seq2seq मॉडल को सभी आवर्ती नेटवर्क की तरह एक समय में एक इनपुट अनुक्रम को संसाधित करना होता है, ट्रांसफॉर्मर आर्किटेक्चर को अनुक्रम पर समानांतर में चलाया जा सकता है। यह बहुत बड़े मॉडलों को प्रशिक्षित और उपयोग करने की अनुमति देता है।

बर्ट और जीपीटी[संपादित करें]

जबकि विभिन्न नामों वाले कई मॉडल हैं, अधिकांश में अंतर्निहित आर्किटेक्चर दो प्रकारों में से एक है: बीईआरटी (2018) [20] एक द्विदिश ट्रांसफार्मर है, जबकि जीपीटी (2018+) [21] [22] यूनिडायरेक्शनल ("ऑटोरेग्रेसिव") हैं ट्रांसफार्मर। ये 2023 तक के मुख्य आर्किटेक्चर हैं।

शब्द की उत्पत्ति और असंबद्धता[संपादित करें]

जबकि लार्ज लैंग्वेज मॉडल्स का शब्द 2018 के आसपास ही उभरा है, इसने 2019 और 2020 में क्रमशः डिस्टिलबर्ट [23] और स्टोकेस्टिक पैरेट्स [24] पेपर जारी होने के साथ दृश्यता प्राप्त की। दोनों ने "बड़े पैमाने पर पूर्व-प्रशिक्षित मॉडल" पर ध्यान केंद्रित किया, एलएलएम के उदाहरण के रूप में बीईआरटी परिवार का हवाला देते हुए, 110एम पैरामीटर से शुरू किया और 340एम पैरामीटर रेंज में मॉडल को "बहुत बड़े एलएम" के रूप में संदर्भित किया।

शायद आश्चर्यजनक रूप से, दोनों प्री-ट्रांसफॉर्मर आरएनएन-आधारित ईएलएमओ - 2018 आर्किटेक्चर का हवाला देते हैं जिसने बीईआरटी को प्रेरित किया - पहले एलएलएम के रूप में, मापदंडों की संख्या (94M), साथ ही प्रीट्रेनिंग डेटासेट (> 1 बी टोकन) का आकार दिया। [25] तुलनीय पैरामीटर आकार के बावजूद, छोटे प्रीट्रेनिंग डेटासेट (आमतौर पर 100M टोकन रेंज में अनुमानित) के कारण मूल ट्रांसफार्मर को आमतौर पर एलएलएम नहीं माना जाता है।

कुल मिलाकर, एलएलएम मॉडल के प्रदर्शन में ~100एम पैरामीटर से 500बी+ पैरामीटर तक सुचारू स्केलिंग और बहुभाषी अनुवाद, अंकगणित, या प्रोग्रामिंग कोड संरचना जैसी उभरती क्षमताओं की प्रगतिशील अनलॉकिंग के कारण, सभी पोस्ट-ईएलएमओ मॉडल को शोधकर्ताओं द्वारा एलएलएम के रूप में संदर्भित किया जाता है। . [26] [27] [28] [29]

भाषाई आधार[संपादित करें]

संज्ञानात्मक भाषाविज्ञान प्राकृतिक भाषा प्रसंस्करण के माध्यम से मन की स्थिति को मापने के लिए एक वैज्ञानिक प्रथम सिद्धांत दिशा प्रदान करता है [30] ताकि कंप्यूटर को पाठ और दस्तावेजों की सामग्री को "समझने" में सक्षम बनाया जा सके, जिसमें उनके भीतर भाषा की प्रासंगिक बारीकियां भी शामिल हैं। एनएलपी का विकासात्मक प्रक्षेपवक्र, जिसे संज्ञानात्मक एनएलपी के रूप में जाना जाता है, बुद्धिमान व्यवहार और प्राकृतिक भाषा की स्पष्ट समझ के अनुकरण के लिए एक एकात्मक भाषा मॉडल के रूप में आधार तैयार करता है। मॉडल का विशेष रूप विश्लेषण किए जाने वाले टोकन के पहले और बाद में प्रस्तुत किए गए टोकन के आधार पर एक वेक्टर डेटाबेस बनाने के लिए पाठ, वाक्य, वाक्यांश या शब्द के एक ब्लॉक को एक टोकन के रूप में मानता है। इसके सामान्यीकृत रूप में एक टोकन को गैर-पाठ्य अनुप्रयोगों के लिए किसी भी प्रासंगिक रूप से प्रासंगिक प्रतीक जैसे पिक्सेल के समूह, गणितीय प्रतीकों, कोडिंग निर्माण, आणविक सूत्र आदि द्वारा प्रतिस्थापित किया जा सकता है। [31]

मॉडल संरचना[संपादित करें]

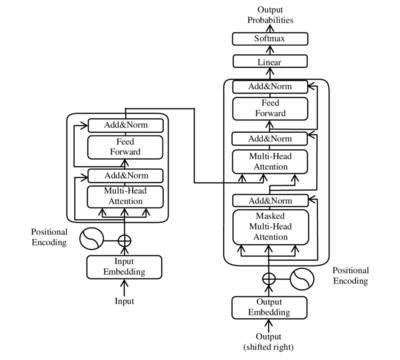

बड़े भाषा मॉडल में आमतौर पर ट्रांसफॉर्मर आर्किटेक्चर का उपयोग किया जाता है, जो 2018 के बाद से अनुक्रमिक डेटा के लिए मानक गहन शिक्षण तकनीक बन गया है। [4] वास्तुकला की एक वैकल्पिक पंक्ति विशेषज्ञों का मिश्रण (एमओई) है, जिसका उपयोग अक्सर Google द्वारा विकसित एआई मॉडल में किया जाता है, जो कम-गेटेड एमओई (2017) से शुरू होता है, [32] और जीशर्ड (2021) [33] और जीएलएएम तक आगे बढ़ता है। (2022)। [34]

सभी ट्रांसफार्मर के प्राथमिक घटक समान होते हैं:

- टोकनाइज़र, जो टेक्स्ट को मशीन-पठनीय प्रतीकों में परिवर्तित करते हैं जिन्हें टोकन कहा जाता है

- एंबेडिंग परतें, जो मशीन-पठनीय प्रतीकों को शब्दार्थ की दृष्टि से सार्थक अभ्यावेदन में परिवर्तित करती हैं

- ट्रांसफार्मर परतें, जो मॉडलों की तर्क क्षमताओं को पूरा करती हैं

ट्रांसफार्मर की परतें दो प्रकार की होती हैं जिन्हें एनकोडर और डिकोडर के नाम से जाना जाता है। जबकि मूल कागज से ट्रांसफार्मर एनकोडर परतों और डिकोडर परतों दोनों से बना था, बाद के काम ने एनकोडर-केवल आर्किटेक्चर ( बीईआरटी ) और डिकोडर-केवल आर्किटेक्चर ( जीपीटी ) का भी पता लगाया है। जबकि तीनों के अपने फायदे और उपयोग हैं, बड़े पैमाने पर प्रशिक्षण के लिए काफी अधिक कुशल होने के कारण डिकोडर-केवल मॉडल बहुत बड़े पैमाने पर प्रमुख रूप हैं।

टोकनीकरण(टोकनाइज़ेसन)[संपादित करें]

एलएलएम गणितीय कार्य हैं जिनके इनपुट और आउटपुट संख्याओं की सूची हैं। नतीजतन, शब्दों को संख्याओं में परिवर्तित किया जाना चाहिए।

सामान्य तौर पर, एलएलएम एक अलग टोकननाइज़र का उपयोग करता है। एक टोकनाइज़र टेक्स्ट और पूर्णांकों की सूचियों के बीच मैप करता है। एलएलएम प्रशिक्षित होने से पहले टोकननाइज़र को आम तौर पर पहले संपूर्ण प्रशिक्षण डेटासेट के लिए अनुकूलित किया जाता है, फिर फ़्रीज़ किया जाता है । एक सामान्य विकल्प बाइट जोड़ी एन्कोडिंग है।

टोकननाइज़र का एक अन्य कार्य टेक्स्ट कम्प्रेशन है, जो गणना को बचाता है। सामान्य शब्द या वाक्यांश जैसे "कहां है" को 7 अक्षरों के बजाय एक टोकन में एन्कोड किया जा सकता है। ओपनएआई जीपीटी श्रृंखला एक टोकननाइज़र का उपयोग करती है जहां 1 टोकन सामान्य अंग्रेजी पाठ में लगभग 4 अक्षरों या लगभग 0.75 शब्दों को मैप करता है। [35] असामान्य अंग्रेजी पाठ कम पूर्वानुमानित है, इस प्रकार कम संपीड़ित है, इस प्रकार एन्कोड करने के लिए अधिक टोकन की आवश्यकता होती है।

टोकनाइज़र मनमाना पूर्णांक आउटपुट नहीं कर सकता। वे आम तौर पर श्रेणी में केवल पूर्णांक ही आउटपुट करते हैं , कहाँ इसका शब्दावली आकार कहा जाता है।

कुछ टोकनाइज़र मनमाने पाठ को संभालने में सक्षम हैं (आम तौर पर सीधे यूनिकोड पर काम करके), लेकिन कुछ नहीं करते हैं। अन-एन्कोडेबल टेक्स्ट का सामना करते समय, एक टोकननाइज़र एक विशेष टोकन (अक्सर 0) आउटपुट करेगा जो "अज्ञात टेक्स्ट" का प्रतिनिधित्व करता है। इसे अक्सर ऐसे लिखा जाता है [यूएनके], जैसे कि बीईआरटी पेपर में।

आमतौर पर इस्तेमाल किया जाने वाला एक और विशेष टोकन है [पीएडी] (अक्सर 1), "पैडिंग" के लिए। इसका उपयोग इसलिए किया जाता है क्योंकि एलएलएम का उपयोग आम तौर पर एक समय में पाठ के बैचों पर किया जाता है, और ये पाठ समान लंबाई में एन्कोड नहीं होते हैं। चूंकि एलएलएम के लिए आम तौर पर इनपुट की आवश्यकता एक ऐसी सरणी होती है जो दांतेदार न हो, छोटे एन्कोडेड टेक्स्ट को तब तक पैड किया जाना चाहिए जब तक कि वे सबसे लंबे टेक्स्ट की लंबाई से मेल न खा जाएं।

उत्पादन[संपादित करें]

एलएलएम का आउटपुट इसकी शब्दावली पर संभाव्यता वितरण है। इसे आमतौर पर इस प्रकार कार्यान्वित किया जाता है:

- एक पाठ प्राप्त करने पर, एलएलएम का बड़ा हिस्सा एक वेक्टर आउटपुट करता है कहाँ इसका शब्दावली आकार (ऊपर परिभाषित) है।

- सदिश प्राप्त करने के लिए सॉफ्टमैक्स फ़ंक्शन के माध्यम से पारित किया जाता है .

इस प्रक्रिया में, वेक्टर इसे आमतौर पर अननॉर्मलाइज़्ड लॉगिट वेक्टर और वेक्टर कहा जाता है संभाव्यता वेक्टर कहा जाता है. वेक्टर के बाद से है प्रविष्टियाँ, सभी गैर-नकारात्मक, और उनका योग 1 है, हम इसे संभाव्यता वितरण के रूप में व्याख्या कर सकते हैं - यानी, यह एलएलएम की शब्दावली पर एक संभाव्यता वितरण है।

ध्यान दें कि सॉफ्टमैक्स फ़ंक्शन को गणितीय रूप से परिभाषित किया गया है जिसमें कोई पैरामीटर भिन्न नहीं है। फलस्वरूप यह प्रशिक्षित नहीं है।

प्रसंग विंडो[संपादित करें]

एलएलएम की संदर्भ विंडो टोकन के सबसे लंबे अनुक्रम की लंबाई है जिसका उपयोग एलएलएम टोकन उत्पन्न करने के लिए कर सकता है। यदि एलएलएम को संदर्भ विंडो से अधिक लंबे अनुक्रम पर टोकन उत्पन्न करना है, तो उसे या तो अनुक्रम को संदर्भ विंडो तक छोटा करना होगा, या कुछ एल्गोरिदमिक संशोधनों का उपयोग करना होगा।

एलएलएम की संदर्भ विंडो 1,000 (1k) से 10k के क्रम पर होती है। विशेष रूप से, OpenAI जून 2023 तक 4k से 16k तक संदर्भ विंडो के साथ GPT-3.5 प्रदान करता है [36]

प्रशिक्षण[संपादित करें]

पूर्व-प्रशिक्षण में, एलएलएम को या तो यह अनुमान लगाने के लिए प्रशिक्षित किया जा सकता है कि खंड कैसे जारी रहेगा, या अपने प्रशिक्षण डेटासेट से एक खंड को देखते हुए, खंड में क्या कमी है। [37] यह या तो हो सकता है

- ऑटोरेग्रेसिव (यानी यह भविष्यवाणी करना कि सेगमेंट कैसे जारी रहेगा, जिस तरह से जीपीटी इसे करते हैं): उदाहरण के लिए एक सेगमेंट दिया गया है "मुझे खाना पसंद है", मॉडल "आइसक्रीम" की भविष्यवाणी करता है, या

- " नकाबपोश " (अर्थात खंड से गायब हिस्सों को भरना, जिस तरह से "बीईआरटी" [38] करता है): उदाहरण के लिए, एक खंड दिया गया है "मुझे

[__] [__]क्रीम पसंद है", मॉडल भविष्यवाणी करता है कि " खाओ" और "बर्फ" गायब हैं।

एलएलएम को सहायक कार्यों पर प्रशिक्षित किया जा सकता है जो डेटा वितरण की उनकी समझ का परीक्षण करते हैं, जैसे कि नेक्स्ट सेंटेंस प्रेडिक्शन (एनएसपी), जिसमें वाक्यों के जोड़े प्रस्तुत किए जाते हैं और मॉडल को भविष्यवाणी करनी चाहिए कि क्या वे प्रशिक्षण कॉर्पस में लगातार दिखाई देते हैं। [38]

आमतौर पर, एलएलएम को एक विशिष्ट हानि फ़ंक्शन को कम करने के लिए प्रशिक्षित किया जाता है: प्रति टोकन औसत नकारात्मक लॉग संभावना (जिसे क्रॉस-एन्ट्रॉपी हानि भी कहा जाता है)। उदाहरण के लिए, यदि एक ऑटोरेग्रेसिव मॉडल, "मुझे खाना पसंद है" दिया गया है, तो संभाव्यता वितरण की भविष्यवाणी करता है तो इस टोकन पर नकारात्मक लॉग संभावना हानि है .

प्रशिक्षण के दौरान, प्रशिक्षण को स्थिर करने के लिए नियमितीकरण हानि का भी उपयोग किया जाता है। हालाँकि नियमितीकरण हानि का उपयोग आमतौर पर परीक्षण और मूल्यांकन के दौरान नहीं किया जाता है। केवल नकारात्मक लॉग संभावना के अलावा और भी कई मूल्यांकन मानदंड हैं। विवरण के लिए नीचे अनुभाग देखें.

डेटासेट का आकार और संपीड़न[संपादित करें]

2018 में, 985 मिलियन शब्दों वाले बुककॉर्पस का उपयोग ओपनएआई के पहले मॉडल, जीपीटी-1 के लिए एक प्रशिक्षण डेटासेट के रूप में किया गया था। [39] उसी वर्ष, बुककॉर्पस और अंग्रेजी विकिपीडिया के संयोजन, कुल 3.3 बिलियन शब्दों का उपयोग BERT के लिए एक प्रशिक्षण डेटासेट के रूप में किया गया था। [38] तब से, खरबों टोकन वाले कॉर्पोरा का उपयोग किया गया, जिससे पिछले डेटासेट में परिमाण के आधार पर वृद्धि हुई। [38]

आमतौर पर, एलएलएम को पूर्ण या अर्ध-सटीक फ्लोटिंग पॉइंट नंबरों (फ्लोट32 और फ्लोट16) के साथ प्रशिक्षित किया जाता है। एक फ्लोट16 में 16 बिट या 2 बाइट्स होते हैं, और इसलिए एक अरब पैरामीटर के लिए 2 गीगाबाइट की आवश्यकता होती है। सबसे बड़े मॉडल में आमतौर पर 100 बिलियन पैरामीटर होते हैं, जिन्हें लोड करने के लिए 200 गीगाबाइट की आवश्यकता होती है, जो उन्हें अधिकांश उपभोक्ता इलेक्ट्रॉनिक्स की सीमा से बाहर रखता है।

प्रशिक्षण के बाद परिमाणीकरण [40] का उद्देश्य प्रशिक्षित मॉडल के अधिकांश प्रदर्शन को संरक्षित करते हुए उसके मापदंडों की सटीकता को कम करके स्थान की आवश्यकता को कम करना है। [41] [42] परिमाणीकरण का सबसे सरल रूप सभी संख्याओं को बिट्स की एक निश्चित संख्या में छोटा कर देता है। प्रति परत एक अलग परिमाणीकरण कोडबुक का उपयोग करके इसे बेहतर बनाया जा सकता है। विशेष रूप से महत्वपूर्ण मापदंडों ("बाहरी वजन") के लिए उच्च परिशुद्धता के साथ, विभिन्न मापदंडों पर अलग-अलग परिशुद्धता लागू करके और सुधार किया जा सकता है। [43]

जबकि क्वांटाइज़्ड मॉडल आम तौर पर जमे हुए होते हैं, और केवल पूर्व-क्वांटाइज़्ड मॉडल को ही फाइनट्यून किया जाता है, क्वांटाइज़्ड मॉडल को अभी भी फाइनट्यून किया जा सकता है। [44]

प्रशिक्षण का मूल्य[संपादित करें]

सॉफ्टवेयर और हार्डवेयर में प्रगति ने 2020 के बाद से लागत को काफी हद तक कम कर दिया है, जैसे कि 2023 में 12-बिलियन-पैरामीटर एलएलएम कम्प्यूटेशनल लागत 72,300 ए100-जीपीयू -घंटे है, जबकि 2020 में 1.5-बिलियन-पैरामीटर एलएलएम के प्रशिक्षण की लागत (जो कि 2020 में अत्याधुनिक से दो परिमाण कम था) $80 हजार और $1.6 मिलियन के बीच था। [45] [46] [47] 2020 के बाद से, तेजी से बड़े मॉडलों में बड़ी रकम का निवेश किया गया। उदाहरण के लिए, 2019 में GPT-2 (यानी 1.5-बिलियन-पैरामीटर मॉडल) के प्रशिक्षण की लागत $50,000 थी, जबकि 2022 में PaLM (यानी 540-बिलियन-पैरामीटर मॉडल) के प्रशिक्षण की लागत $8 मिलियन थी। [48]

ट्रांसफार्मर-आधारित एलएलएम के लिए, प्रशिक्षण लागत अनुमान लागत से बहुत अधिक है। एक टोकन पर प्रशिक्षण के लिए प्रति पैरामीटर 6 एफएलओपी की लागत आती है, जबकि एक टोकन पर अनुमान लगाने के लिए प्रति पैरामीटर 1 से 2 एफएलओपी की लागत आती है। [49]

डाउनस्ट्रीम कार्यों के लिए आवेदन[संपादित करें]

2018 और 2020 के बीच, किसी विशिष्ट कार्य के लिए एलएलएम का उपयोग करने की मानक विधि अतिरिक्त कार्य-विशिष्ट प्रशिक्षण के साथ मॉडल को बेहतर बनाना था। इसके बाद ही यह पता चला कि एलएलएम, जैसे जीपीटी-3, विशेष रूप से प्रशिक्षित किए बिना विभिन्न कार्यों को हल कर सकते हैं। इसके बजाय, समान समस्याओं और उनके संबंधित समाधानों के कुछ उदाहरणों का उपयोग करके उन्हें "संकेत" दिया जाना पर्याप्त है। [4] कुछ-शॉट प्रॉम्प्टिंग ने कभी-कभी अनुवाद, प्रश्न उत्तर, करीबी कार्य, स्पष्ट शब्दों और एक वाक्य में एक नए शब्द का उपयोग करने के क्षेत्रों में पुराने फाइन-ट्यूनिंग से भी बेहतर परिणाम दिए हैं। [50] ऐसे संकेतों के निर्माण और अनुकूलन को प्रॉम्प्ट इंजीनियरिंग कहा जाता है।

फाइन-ट्यूनिंग से लेकर संकेत(प्रोम्प्ट) देने तक[संपादित करें]

पुराना दृष्टिकोण किसी विशिष्ट समस्या (जैसे भावना विश्लेषण, नामित-इकाई पहचान, या भाषण के भाग की टैगिंग ) को हल करने के उद्देश्य से मौजूदा पूर्व-प्रशिक्षित भाषा मॉडल को फिर से प्रशिक्षित करके (पर्यवेक्षित तरीके से) ठीक करना था। ), जो भाषा मॉडल की अंतिम परत को डाउनस्ट्रीम कार्य के आउटपुट से जोड़ने वाले भार के एक नए सेट को पेश करके प्राप्त किया जाता है। भाषा मॉडल के मूल भार "जमे हुए" हो सकते हैं, जैसे कि उन्हें आउटपुट से जोड़ने वाले भार की केवल नई परत ही प्रशिक्षण के दौरान सीखी जाती है। वैकल्पिक रूप से, मूल वज़न को छोटे अपडेट प्राप्त हो सकते हैं (संभवतः पहले की परतें जमी हुई हों)। [38]

नए दृष्टिकोण में जिसे प्रॉम्प्टिंग कहा जाता है और जीपीटी-3 द्वारा लोकप्रिय बनाया गया है, [51] एक एलएलएम को पूर्णता प्रदान की जाती है ( अनुमान के माध्यम से)। उदाहरण के लिए, कुछ-शॉट प्रॉम्प्टिंग में, प्रॉम्प्ट में समान समस्या-समाधान युग्मों के कुछ उदाहरण शामिल होते हैं। [4]

नीचे एक भावना विश्लेषण का उदाहरण दिया गया है, जिसमें फिल्म समीक्षा की भावना को लेबल किया गया है: [51]

समीक्षा: यह फिल्म बेकार है। भावना: नकारात्मक

समीक्षा: यह फिल्म शानदार है! भावना:

यदि मॉडल "सकारात्मक" आउटपुट देता है, तो उसने कार्य को सही ढंग से हल कर लिया है। शून्य-शॉट प्रॉम्प्टिंग में, कोई हल किए गए उदाहरण प्रदान नहीं किए जाते हैं। [45] [50]

अनुदेश ट्यूनिंग[संपादित करें]

अक्सर, निर्देश ट्यूनिंग आवश्यक है क्योंकि अन्यथा एक कृत्रिम तंत्रिका नेटवर्क, उपयोगकर्ता के निर्देश के जवाब में "हैमलेट में दर्शाए गए मुख्य विषयों के बारे में एक निबंध लिखें," एक प्रतिक्रिया उत्पन्न कर सकता है जैसे "यदि आप 17 मार्च के बाद निबंध जमा करते हैं, तो आपका कॉर्पस में इस पाठ्य क्रम की आवृत्ति के आधार पर देरी के प्रत्येक दिन के लिए ग्रेड में 10% की कमी की जाएगी। यह केवल निर्देश ट्यूनिंग के माध्यम से है कि मॉडल सीखता है कि विशिष्ट निर्देशों के लिए प्रतिक्रिया में वास्तव में क्या होना चाहिए।

अनुदेश ट्यूनिंग के लिए विभिन्न तकनीकों को व्यवहार में लागू किया गया है। एक उदाहरण, "स्व-निर्देश", उदाहरणों के एक प्रशिक्षण सेट पर भाषा मॉडल को ठीक करता है जो स्वयं एलएलएम द्वारा उत्पन्न होता है (मानव-निर्मित उदाहरणों के एक छोटे प्रारंभिक सेट से बूटस्ट्रैप किया गया )। [52]

सुदृढीकरण सीखने द्वारा फ़ाइनट्यूनिंग[संपादित करें]

ओपनएआई के इंस्ट्रक्टजीपीटी प्रोटोकॉल में मानव-जनित (त्वरित, प्रतिक्रिया) जोड़े के डेटासेट पर पर्यवेक्षित फाइन-ट्यूनिंग शामिल है, इसके बाद मानव प्रतिक्रिया (आरएलएचएफ) से सुदृढीकरण सीखना, जिसमें एक इनाम मॉडल को मानव प्राथमिकताओं के डेटासेट पर पर्यवेक्षित-सीखा गया था। इस इनाम मॉडल का उपयोग समीपस्थ नीति अनुकूलन द्वारा एलएलएम को प्रशिक्षित करने के लिए किया गया था। [53]

उपकरण का उपयोग[संपादित करें]

कुछ ऐसे कार्य हैं, जिन्हें सिद्धांत रूप में, किसी भी एलएलएम द्वारा हल नहीं किया जा सकता है, कम से कम बाहरी टूल या अतिरिक्त सॉफ़्टवेयर के उपयोग के बिना नहीं। ऐसे कार्य का एक उदाहरण उपयोगकर्ता के इनपुट '354 * 139 =' का जवाब देना है, बशर्ते कि एलएलएम को पहले से ही अपने प्रशिक्षण कोष में इस गणना की निरंतरता का सामना नहीं करना पड़ा हो। ऐसे मामलों में, एलएलएम को रनिंग प्रोग्राम कोड का सहारा लेना पड़ता है जो परिणाम की गणना करता है, जिसे बाद में उसकी प्रतिक्रिया में शामिल किया जा सकता है। दूसरा उदाहरण है 'अभी क्या समय हुआ है? यह 'है, जहां एक अलग प्रोग्राम दुभाषिया को कंप्यूटर पर सिस्टम समय प्राप्त करने के लिए एक कोड निष्पादित करने की आवश्यकता होगी, ताकि एलएलएम इसे अपने उत्तर में शामिल कर सके। [54] [55] इस बुनियादी रणनीति को जनरेट किए गए कार्यक्रमों और अन्य नमूनाकरण रणनीतियों के कई प्रयासों से परिष्कृत किया जा सकता है। [56]

आम तौर पर, टूल का उपयोग करने के लिए एलएलएम प्राप्त करने के लिए, किसी को टूल-उपयोग के लिए इसे परिष्कृत करना होगा। यदि उपकरणों की संख्या सीमित है, तो फ़ाइनट्यूनिंग केवल एक बार की जा सकती है। यदि टूल की संख्या मनमाने ढंग से बढ़ सकती है, जैसा कि ऑनलाइन एपीआई सेवाओं के साथ होता है, तो एलएलएम को एपीआई दस्तावेज़ पढ़ने और एपीआई को सही ढंग से कॉल करने में सक्षम होने के लिए ठीक किया जा सकता है। [57] [58]

उपकरण के उपयोग का एक सरल रूप पुनर्प्राप्ति संवर्धित पीढ़ी है: दस्तावेज़ पुनर्प्राप्ति के साथ एक एलएलएम को बढ़ाना, कभी-कभी वेक्टर डेटाबेस का उपयोग करना। किसी क्वेरी को देखते हुए, सबसे प्रासंगिक दस्तावेज़ पुनर्प्राप्त करने के लिए एक दस्तावेज़ रिट्रीवर को बुलाया जाता है (आमतौर पर पहले क्वेरी और दस्तावेज़ों को वेक्टर में एन्कोड करके मापा जाता है, फिर क्वेरी वेक्टर के यूक्लिडियन मानदंड में निकटतम वेक्टर वाले दस्तावेज़ ढूंढते हैं)। एलएलएम तब क्वेरी और पुनर्प्राप्त दस्तावेज़ दोनों के आधार पर एक आउटपुट उत्पन्न करता है। [59]

एजेंसी[संपादित करें]

एलएलएम एक भाषा मॉडल है, जो एक एजेंट नहीं है क्योंकि इसका कोई लक्ष्य नहीं है, लेकिन इसका उपयोग एक बुद्धिमान एजेंट के एक घटक के रूप में किया जा सकता है। [60]

ReAct (Reason+Act; "कारण + अधिनियम") विधि एलएलएम को एक योजनाकार के रूप में उपयोग करते हुए, एलएलएम से एक एजेंट का निर्माण करती है। एलएलएम को "ज़ोर से सोचने" के लिए प्रेरित किया जाता है। विशेष रूप से, भाषा मॉडल को पर्यावरण के पाठ्य विवरण, एक लक्ष्य, संभावित कार्यों की एक सूची और अब तक के कार्यों और टिप्पणियों के रिकॉर्ड के साथ प्रेरित किया जाता है। यह किसी कार्य को उत्पन्न करने से पहले एक या अधिक विचार उत्पन्न करता है, जिसे बाद में वातावरण में क्रियान्वित किया जाता है। [61] एलएलएम योजनाकार को दिया गया पर्यावरण का भाषाई विवरण पर्यावरण का वर्णन करने वाले पेपर का LaTeX कोड भी हो सकता है। [62]

रिफ्लेक्सियन विधि [63] एक ऐसे एजेंट का निर्माण करती है जो कई प्रकरणों में सीखता है। प्रत्येक एपिसोड के अंत में, एलएलएम को एपिसोड का रिकॉर्ड दिया जाता है, और "सीखे गए सबक" के बारे में सोचने के लिए प्रेरित किया जाता है, जिससे उसे अगले एपिसोड में बेहतर प्रदर्शन करने में मदद मिलेगी। ये "सीखे गए सबक" अगले एपिसोड में एजेंट को दिए जाते हैं।

मोंटे कार्लो ट्री सर्च एलएलएम को रोलआउट अनुमान के रूप में उपयोग कर सकता है। जब एक प्रोग्रामेटिक विश्व मॉडल उपलब्ध नहीं होता है, तो एलएलएम को विश्व मॉडल के रूप में कार्य करने के लिए पर्यावरण के विवरण के साथ भी प्रेरित किया जा सकता है। [64]

ओपन-एंडेड अन्वेषण के लिए, एक एलएलएम का उपयोग उनकी "रोचकता" के लिए टिप्पणियों को स्कोर करने के लिए किया जा सकता है, जिसका उपयोग सामान्य (गैर-एलएलएम) सुदृढीकरण सीखने वाले एजेंट को मार्गदर्शन करने के लिए इनाम संकेत के रूप में किया जा सकता है। [65] वैकल्पिक रूप से, यह पाठ्यक्रम सीखने के लिए तेजी से कठिन कार्यों का प्रस्ताव कर सकता है। [66] व्यक्तिगत क्रियाओं को आउटपुट करने के बजाय, एक एलएलएम योजनाकार जटिल क्रिया अनुक्रमों के लिए "कौशल" या फ़ंक्शन का निर्माण भी कर सकता है। कौशल को संग्रहीत किया जा सकता है और बाद में लागू किया जा सकता है, जिससे योजना में अमूर्तता के स्तर को बढ़ाया जा सकता है। [66]

एलएलएम-संचालित एजेंट अपने पिछले संदर्भों की दीर्घकालिक स्मृति रख सकते हैं, और स्मृति को रिट्रीवल ऑगमेंटेड जेनरेशन की तरह ही पुनर्प्राप्त किया जा सकता है। ऐसे कई एजेंट सामाजिक रूप से बातचीत कर सकते हैं। [67]

बहुपद्धतिपरक[संपादित करें]

मल्टीमॉडैलिटी का अर्थ है "कई तौर-तरीके होना", और "मोडैलिटी" का अर्थ है एक प्रकार का इनपुट, जैसे वीडियो, छवि, ऑडियो, टेक्स्ट, प्रोप्रियोसेप्शन, आदि। [68] ऐसे कई एआई मॉडल हैं जिन्हें विशेष रूप से एक मोडेलिटी को ग्रहण करने और दूसरे मोडेलिटी को आउटपुट करने के लिए प्रशिक्षित किया गया है, जैसे छवि को लेबल करने के लिए एलेक्सनेट,[69] छवि-पाठ से पाठ के लिए दृश्य प्रश्न उत्तर, [70] और पाठ से पाठ के लिए वाक् पहचान। मल्टीमॉडल एलएलएम का एक समीक्षा लेख है। [71]

एलएलएम से मल्टीमॉडल मॉडल बनाने की एक सामान्य विधि एक प्रशिक्षित एनकोडर के आउटपुट को "टोकनाइज़" करना है। सीधे तौर पर, कोई एक एलएलएम का निर्माण कर सकता है जो छवियों को इस प्रकार समझ सकता है: एक प्रशिक्षित एलएलएम लें, और एक प्रशिक्षित छवि एनकोडर लें . एक छोटा बहुस्तरीय परसेप्ट्रॉन बनाएं , ताकि किसी भी छवि के लिए , पोस्ट-प्रोसेस्ड वेक्टर एन्कोडेड टोकन के समान आयाम हैं। वह एक "छवि टोकन" है। फिर, कोई टेक्स्ट टोकन और इमेज टोकन को इंटरलीव कर सकता है। फिर कंपाउंड मॉडल को एक छवि-पाठ डेटासेट पर परिष्कृत किया जाता है। मॉडल को बेहतर बनाने के लिए इस बुनियादी निर्माण को अधिक परिष्कार के साथ लागू किया जा सकता है। स्थिरता में सुधार के लिए छवि एन्कोडर को फ़्रीज़ किया जा सकता है। [72]

फ्लेमिंगो ने टोकनाइजेशन विधि की प्रभावशीलता का प्रदर्शन किया, स्क्रैच से प्रशिक्षित मॉडल की तुलना में दृश्य प्रश्न उत्तर पर बेहतर प्रदर्शन करने के लिए पूर्व-प्रशिक्षित भाषा मॉडल और छवि एनकोडर की एक जोड़ी को ठीक किया। [73] Google PaLM मॉडल को टोकननाइजेशन विधि का उपयोग करके मल्टीमॉडल मॉडल PaLM-E में परिष्कृत किया गया और रोबोटिक नियंत्रण पर लागू किया गया। [74] छवि इनपुट, [75] और वीडियो इनपुट की अनुमति देने के लिए टोकननाइजेशन विधि का उपयोग करके LLaMA मॉडल को मल्टीमॉडल भी बना दिया गया है। [76]

GPT-4 इनपुट के रूप में टेक्स्ट और छवि दोनों का उपयोग कर सकता है, [77] जबकि Google जेमिनी के मल्टीमॉडल होने की उम्मीद है। [78]

गुण[संपादित करें]

पूर्वप्रशिक्षण डेटासेट(तथ्यसमूह)[संपादित करें]

बड़े भाषा मॉडल (एलएलएम) आम तौर पर बड़ी मात्रा में पाठ्य डेटा पर पूर्व-प्रशिक्षित होते हैं जो विभिन्न प्रकार के डोमेन और भाषाओं में फैले होते हैं। [79] प्री-ट्रेनिंग डेटा के कुछ प्रसिद्ध स्रोतों में कॉमन क्रॉल, द पाइल, मैसिवटेक्स्ट, [80] विकिपीडिया और गिटहब शामिल हैं। जबकि अधिकांश ओपन-सोर्स एलएलएम सार्वजनिक रूप से उपलब्ध डेटा का उपयोग करते हैं, निजी डेटा का उपयोग पूर्व-प्रशिक्षण के लिए भी किया जा सकता है। [81] प्री-ट्रेनिंग डेटा विभिन्न चरणों के माध्यम से कच्चे पाठ को प्रीप्रोसेस करके प्राप्त किया जाता है, जैसे डी-डुप्लीकेशन, उच्च-विषाक्तता अनुक्रमों को फ़िल्टर करना, निम्न-गुणवत्ता वाले डेटा को त्यागना, और बहुत कुछ। [82] यह अनुमान लगाया गया है कि भाषा डेटा का स्टॉक सालाना 7% बढ़ता है, और उच्च गुणवत्ता वाला भाषा डेटा 2022 अक्टूबर तक 4.6-17 ट्रिलियन शब्दों के भीतर है। [83] एलएलएम में पूर्व-प्रशिक्षण डेटा के व्यापक उपयोग से डेटा संदूषण होता है, [84] जो तब होता है जब मूल्यांकन डेटा को पूर्व-प्रशिक्षण डेटा में शामिल किया जाता है, जिससे बेंचमार्क मूल्यांकन के दौरान मॉडल प्रदर्शन प्रभावित होता है।

स्केलिंग कानून और आकस्मिक क्षमताएं[संपादित करें]

निम्नलिखित चार हाइपर-पैरामीटर एलएलएम की विशेषता बताते हैं:

- (पूर्व-)प्रशिक्षण की लागत ( ),

- कृत्रिम तंत्रिका नेटवर्क का आकार, जैसे मापदंडों की संख्या (अर्थात् इसकी परतों में न्यूरॉन्स की मात्रा, उनके बीच भार की मात्रा और पूर्वाग्रह),

- इसके (पूर्व-)प्रशिक्षण डेटासेट का आकार (अर्थात कॉर्पस में टोकन की संख्या, ),

- (पूर्व)प्रशिक्षण के बाद प्रदर्शन।

वे सरल सांख्यिकीय कानूनों से संबंधित हैं, जिन्हें "स्केलिंग कानून" कहा जाता है। एलएलएम के लिए एक विशेष स्केलिंग कानून (" चिन्चिला स्केलिंग ") एक युग के लिए ऑटोरेग्रेसिव रूप से प्रशिक्षित होता है, लॉग-लॉग लर्निंग रेट शेड्यूल के साथ, यह बताता है कि: [85]

- मॉडल के प्रशिक्षण की लागत FLOPs में है।

- मॉडल में पैरामीटरों की संख्या है.

- प्रशिक्षण सेट में टोकन की संख्या है।

- परीक्षण डेटासेट पर प्रशिक्षित एलएलएम द्वारा प्राप्त प्रति टोकन ( नैट /टोकन) का औसत नकारात्मक लॉग-संभावना हानि है।

और सांख्यिकीय हाइपर-पैरामीटर हैं

- , जिसका अर्थ है कि एक टोकन पर प्रशिक्षित करने के लिए प्रति पैरामीटर 6 FLOPs की लागत आती है। [49] ध्यान दें कि प्रशिक्षण लागत अनुमान लागत से बहुत अधिक है, जहां एक टोकन पर अनुमान लगाने के लिए प्रति पैरामीटर 1 से 2 एफएलओपी की लागत आती है।

जब कोई y-अक्ष से सबसे अच्छा प्रदर्शन घटाता है जिसे x-अक्ष मात्रा के अनंत स्केलिंग के साथ भी प्राप्त किया जा सकता है, तो बड़े मॉडल का प्रदर्शन, विभिन्न कार्यों पर मापा जाता है, अन्य (छोटे आकार और) का एक रैखिक एक्सट्रपलेशन प्रतीत होता है लॉग-लॉग प्लॉट पर मध्यम आकार) मॉडल का प्रदर्शन। हालाँकि, कभी-कभी रेखा का ढलान एक ढलान से दूसरे बिंदु पर स्थानांतरित हो जाता है जिसे डाउनस्ट्रीम स्केलिंग कानूनों में ब्रेक के रूप में संदर्भित किया जाता है [86], जो चापों से जुड़े रैखिक खंडों की एक श्रृंखला के रूप में दिखाई देता है; ऐसा लगता है कि बड़े मॉडल इस बिंदु पर "आकस्मिक क्षमताएं" प्राप्त कर लेते हैं। [51] [87] इन क्षमताओं को प्रोग्राम-इन या डिज़ाइन किए जाने के बजाय खोजा जाता है, कुछ मामलों में एलएलएम को सार्वजनिक रूप से तैनात किए जाने के बाद ही। [2]

उभरती क्षमताओं में शामिल हैं:

- रिपोर्ट किए गए अंकगणित, अंतर्राष्ट्रीय ध्वन्यात्मक वर्णमाला को डिकोड करना, किसी शब्द के अक्षरों को सुलझाना, संदर्भ में शब्द को स्पष्ट करना,[51][88][89] पाठ में दर्शाए गए स्थानिक शब्दों, कार्डिनल दिशाओं और रंग शब्दों को परिवर्तित करना (उदाहरण के लिए, [0, 0, 1; 0, 0, 0; 0, 0, 0] पर "उत्तर-पूर्व" का उत्तर देना),[90] और अन्य।

- चेन-ऑफ़-थॉट प्रॉम्प्टिंग : चेन-ऑफ़-थॉट प्रॉम्प्टिंग द्वारा मॉडल आउटपुट में सुधार तभी किया जाता है जब मॉडल का आकार 62B से अधिक हो। छोटे मॉडल बेहतर प्रदर्शन करते हैं जब उन्हें बिना किसी विचार के तुरंत उत्तर देने के लिए कहा जाता है। [91]

- हिंग्लिश (हिंदी और अंग्रेजी का एक संयोजन) के पैराग्राफ में आपत्तिजनक सामग्री की पहचान करना, और किस्वाहिली कहावतों के समान अंग्रेजी समकक्ष तैयार करना। [92]

शेफ़र एट. अल. तर्क है कि उभरती हुई क्षमताएँ अप्रत्याशित रूप से अर्जित नहीं की जाती हैं, बल्कि एक सुचारु स्केलिंग कानून के अनुसार पूर्वानुमानित रूप से अर्जित की जाती हैं। लेखकों ने बहुविकल्पीय प्रश्नों को हल करने वाले एलएलएम के एक खिलौना सांख्यिकीय मॉडल पर विचार किया, और दिखाया कि यह सांख्यिकीय मॉडल, अन्य प्रकार के कार्यों के लिए संशोधित, इन कार्यों पर भी लागू होता है। [31]

होने देना पैरामीटर गिनती की संख्या हो, और मॉडल का प्रदर्शन हो:

- When , then is an exponential curve (before it hits the plateau at one), which looks like emergence.

- When , then the plot is a straight line (before it hits the plateau at zero), which does not look like emergence.

- When , then is a step-function, which looks like emergence.

व्याख्या[संपादित करें]

बड़े भाषा मॉडल अपने आप में "ब्लैक बॉक्स" हैं, और यह स्पष्ट नहीं है कि वे भाषाई कार्य कैसे कर सकते हैं। एलएलएम कैसे काम करता है, इसे समझने के लिए कई विधियाँ हैं।

यंत्रवत व्याख्या का उद्देश्य प्रतीकात्मक एल्गोरिदम की खोज करके एलएलएम को रिवर्स-इंजीनियर करना है जो एलएलएम द्वारा किए गए अनुमान का अनुमान लगाता है। एक उदाहरण ओथेलो-जीपीटी है, जहां एक छोटे ट्रांसफार्मर को कानूनी ओथेलो चाल की भविष्यवाणी करने के लिए प्रशिक्षित किया जाता है। यह पाया गया है कि ओथेलो बोर्ड का एक रैखिक प्रतिनिधित्व है, और प्रतिनिधित्व को संशोधित करने से अनुमानित कानूनी ओथेलो चालें सही तरीके से बदल जाती हैं। [93] [94] दूसरे उदाहरण में, एक छोटे ट्रांसफार्मर को कारेल प्रोग्राम पर प्रशिक्षित किया जाता है। ओथेलो-जीपीटी उदाहरण के समान, कारेल प्रोग्राम शब्दार्थ का एक रैखिक प्रतिनिधित्व है, और प्रतिनिधित्व को संशोधित करने से आउटपुट सही तरीके से बदल जाता है। मॉडल सही प्रोग्राम भी तैयार करता है जो प्रशिक्षण सेट की तुलना में औसतन छोटे होते हैं। [95]

एक अन्य उदाहरण में, लेखकों ने मॉड्यूलर अंकगणितीय जोड़ पर छोटे ट्रांसफार्मर को प्रशिक्षित किया। परिणामी मॉडल रिवर्स-इंजीनियर किए गए थे, और यह पता चला कि उन्होंने असतत फूरियर ट्रांसफॉर्म का उपयोग किया था। [96]

समझ और बुद्धि[संपादित करें]

2022 के एक सर्वेक्षण में जब एनएलपी शोधकर्ताओं से पूछा गया कि क्या (बिना ट्यून किए गए) एलएलएम "कुछ गैर-तुच्छ अर्थों में प्राकृतिक भाषा को (कभी भी) समझ सकते हैं" तो वे समान रूप से विभाजित थे। [97] "एलएलएम समझ" के समर्थकों का मानना है कि कुछ एलएलएम क्षमताएं, जैसे गणितीय तर्क, कुछ अवधारणाओं को "समझने" की क्षमता दर्शाती हैं। माइक्रोसॉफ्ट की एक टीम ने 2023 में तर्क दिया कि GPT-4 "गणित, कोडिंग, दृष्टि, चिकित्सा, कानून, मनोविज्ञान और अन्य जैसे नवीन और कठिन कार्यों को हल कर सकता है" और GPT-4 को "एक कृत्रिम सामान्य बुद्धि प्रणाली के प्रारंभिक (अभी तक अधूरा) संस्करण के रूप में देखा जा सकता है": "क्या कोई तर्कसंगत रूप से कह सकता है कि एक प्रणाली जो सॉफ्टवेयर इंजीनियरिंग उम्मीदवारों के लिए परीक्षा उत्तीर्ण करती है वह वास्तव में बुद्धिमान नहीं है?" [98] [99] कुछ शोधकर्ता एलएलएम को "एलियन इंटेलिजेंस" के रूप में वर्णित करते हैं। [100] उदाहरण के लिए, अनुमान के सीईओ कॉनर लीही अनट्यून किए गए एलएलएम को गूढ़ एलियन " शॉगगोथ्स " की तरह मानते हैं, और मानते हैं कि आरएलएचएफ ट्यूनिंग एलएलएम के आंतरिक कामकाज को अस्पष्ट करते हुए एक "मुस्कुराहट वाला मुखौटा" बनाता है: "यदि आप इसे बहुत दूर नहीं धकेलते हैं, तो स्माइली चेहरा बना रहता है। लेकिन फिर आप इसे [एक अप्रत्याशित] संकेत देते हैं, और अचानक आपको पागलपन, अजीब विचार प्रक्रियाओं और स्पष्ट रूप से गैर-मानवीय समझ का यह विशाल आधार दिखाई देता है।" [101] [102]

इसके विपरीत, "एलएलएम में समझ की कमी" स्कूल के कुछ समर्थकों का मानना है कि मौजूदा एलएलएम "बस मौजूदा लेखन को रीमिक्स और पुनर्संयोजित कर रहे हैं", या मौजूदा एलएलएम में भविष्यवाणी कौशल, तर्क कौशल, एजेंसी और व्याख्यात्मकता में कमी की ओर इशारा करते हैं। [97] उदाहरण के लिए, जीपीटी4 में योजना बनाने और वास्तविक समय में सीखने में स्वाभाविक कमी है। [99] जेनरेटिव एलएलएम को आत्मविश्वास से उन तथ्यों के दावों पर जोर देते हुए देखा गया है जो उनके प्रशिक्षण डेटा द्वारा उचित नहीं लगते हैं, एक ऐसी घटना जिसे " मतिभ्रम " कहा गया है। [103] न्यूरोसाइंटिस्ट टेरेंस सेजनोव्स्की ने तर्क दिया है कि "एलएलएम की बुद्धिमत्ता पर विशेषज्ञों की अलग-अलग राय बताती है कि प्राकृतिक बुद्धिमत्ता पर आधारित हमारे पुराने विचार अपर्याप्त हैं"। [97]

मूल्यांकन[संपादित करें]

विकलता[संपादित करें]

किसी भाषा मॉडल के प्रदर्शन का सबसे अधिक इस्तेमाल किया जाने वाला माप किसी दिए गए पाठ कोष पर उसकी विकलता है। विकलता इस बात का माप है कि कोई मॉडल किसी डेटासेट की सामग्री की कितनी अच्छी तरह भविष्यवाणी करने में सक्षम है; मॉडल डेटासेट को जितनी अधिक संभावना प्रदान करेगा, उलझन उतनी ही कम होगी। गणितीय रूप से, उलझन को प्रति टोकन औसत नकारात्मक लॉग संभावना के घातांक के रूप में परिभाषित किया गया है:

यहाँ टेक्स्ट कॉर्पस में टोकन की संख्या है, और "टोकन के लिए संदर्भ " प्रयुक्त एलएलएम के विशिष्ट प्रकार पर निर्भर करता है। यदि एलएलएम ऑटोरेग्रेसिव है, तो "टोकन के लिए संदर्भ "टोकन से पहले प्रदर्शित होने वाला पाठ का खंड है . यदि एलएलएम छिपा हुआ है, तो "टोकन के लिए संदर्भ "टोकन के आसपास पाठ का खंड है .

क्योंकि भाषा मॉडल उनके प्रशिक्षण डेटा पर हावी हो सकते हैं, मॉडल का मूल्यांकन आमतौर पर अनदेखे डेटा के परीक्षण सेट पर उनकी विकलता के आधार पर किया जाता है। [38] यह बड़े भाषा मॉडल के मूल्यांकन के लिए विशेष चुनौतियाँ प्रस्तुत करता है। जैसे-जैसे उन्हें वेब से बड़े पैमाने पर निकाले गए पाठ के बड़े संग्रह पर प्रशिक्षित किया जाता है, यह संभावना बढ़ती जा रही है कि मॉडल के प्रशिक्षण डेटा में अनजाने में किसी दिए गए परीक्षण सेट के हिस्से शामिल हो जाते हैं। [50]

कार्य-विशिष्ट डेटासेट और बेंचमार्क[संपादित करें]

अधिक विशिष्ट डाउनस्ट्रीम कार्यों पर भाषा मॉडल की क्षमताओं का मूल्यांकन करने के लिए बड़ी संख्या में परीक्षण डेटासेट और बेंचमार्क भी विकसित किए गए हैं। परीक्षण को सामान्य ज्ञान, सामान्य ज्ञान तर्क और गणितीय समस्या-समाधान सहित विभिन्न क्षमताओं का मूल्यांकन करने के लिए डिज़ाइन किया जा सकता है।

मूल्यांकन डेटासेट की एक व्यापक श्रेणी प्रश्न उत्तर डेटासेट है, जिसमें प्रश्नों के जोड़े और सही उत्तर शामिल हैं, उदाहरण के लिए, ("क्या सैन जोस शार्क ने स्टेनली कप जीता है?", "नहीं")। [104] एक प्रश्न उत्तर देने वाले कार्य को "खुली किताब" माना जाता है यदि मॉडल के संकेत में वह पाठ शामिल है जिससे अपेक्षित उत्तर प्राप्त किया जा सकता है (उदाहरण के लिए, पिछले प्रश्न को कुछ पाठ के साथ जोड़ा जा सकता है जिसमें वाक्य शामिल है "शार्क एक बार स्टेनली कप फाइनल में आगे बढ़े हैं, 2016 में पिट्सबर्ग पेंगुइन से हार गए।" [104]). अन्यथा, कार्य को "बंद किताब" माना जाता है, और मॉडल को प्रशिक्षण के दौरान रखे गए ज्ञान पर आधारित होना चाहिए। [105] आमतौर पर उपयोग किए जाने वाले प्रश्न उत्तर डेटासेट के कुछ उदाहरणों में ट्रुथफुलक्यूए, वेब क्वेश्चन्स, ट्रिवियाक्यूए और एसक्यूएडी शामिल हैं। [105]

मूल्यांकन डेटासेट पाठ पूर्णता का रूप भी ले सकता है, जिसमें मॉडल किसी संकेत को पूरा करने के लिए सबसे संभावित शब्द या वाक्य का चयन करता है, उदाहरण के लिए: "ऐलिस बॉब की मित्र थी। ऐलिस अपने दोस्त, ____ से मिलने गई थी। [50]

कुछ समग्र बेंचमार्क भी विकसित किए गए हैं जो विभिन्न मूल्यांकन डेटासेट और कार्यों की विविधता को जोड़ते हैं। उदाहरणों में GLUE, SuperGLUE, MMLU, BIG-बेंच और HELM शामिल हैं। [106] [105]

शेष पर पर्यवेक्षित फाइन-ट्यूनिंग करने के बाद मूल्यांकन डेटासेट के रुके हुए हिस्से पर परिणामों की रिपोर्ट करना पहले मानक था। पूर्व-प्रशिक्षित मॉडल का सीधे तौर पर प्रॉम्प्टिंग तकनीकों के माध्यम से मूल्यांकन करना अब अधिक आम हो गया है, हालांकि शोधकर्ता विशेष कार्यों के लिए प्रॉम्प्ट तैयार करने के तरीके के विवरण में भिन्न होते हैं, विशेष रूप से इस संबंध में कि हल किए गए कार्यों के कितने उदाहरण प्रॉम्प्ट से जुड़े हैं (यानी एन -शॉट प्रॉम्प्टिंग में एन का मूल्य)।

प्रतिकूल रूप से निर्मित मूल्यांकन[संपादित करें]

बड़े भाषा मॉडलों के सुधार की तीव्र गति के कारण, मूल्यांकन बेंचमार्क को कम जीवनकाल का सामना करना पड़ा है, अत्याधुनिक मॉडल तेजी से मौजूदा बेंचमार्क को "संतृप्त" कर रहे हैं, मानव एनोटेटर्स के प्रदर्शन को पार कर रहे हैं, जिससे बेंचमार्क को और अधिक चुनौतीपूर्ण कार्यों के साथ बदलने या बढ़ाने के प्रयास किए जा रहे हैं। [107] इसके अलावा, "शॉर्टकट लर्निंग" के मामले भी हैं जिनमें एआई कभी-कभी सही प्रतिक्रियाओं का अनुमान लगाने के लिए सतही परीक्षण प्रश्न शब्दों में सांख्यिकीय सहसंबंधों का उपयोग करके बहुविकल्पीय परीक्षणों पर "धोखा" देते हैं, बिना पूछे गए वास्तविक प्रश्न को समझे बिना। [97]

कुछ डेटासेट का निर्माण प्रतिकूल रूप से किया गया है, विशेष समस्याओं पर ध्यान केंद्रित करते हुए, जिन पर मौजूदा भाषा मॉडल मनुष्यों की तुलना में असामान्य रूप से खराब प्रदर्शन करते हैं। एक उदाहरण ट्रूथफुलक्यूए डेटासेट है, एक प्रश्न उत्तर देने वाला डेटासेट जिसमें 817 प्रश्न हैं, जो भाषा मॉडल उन झूठों की नकल करके गलत उत्तर देने के लिए अतिसंवेदनशील होते हैं जिन्हें प्रशिक्षण के दौरान उन्हें बार-बार उजागर किया गया था। उदाहरण के लिए, एक एलएलएम इस प्रश्न का उत्तर "नहीं" दे सकता है "क्या आप एक बूढ़े कुत्ते को नई तरकीबें सिखा सकते हैं?" अंग्रेजी मुहावरे के संपर्क में आने के कारण आप एक बूढ़े कुत्ते को नई तरकीबें नहीं सिखा सकते, भले ही यह अक्षरशः सत्य नहीं है। [108]

प्रतिकूल मूल्यांकन डेटासेट का एक अन्य उदाहरण स्वैग और उसके उत्तराधिकारी, हेलास्वैग, समस्याओं का संग्रह है जिसमें एक पाठ मार्ग को पूरा करने के लिए कई विकल्पों में से एक का चयन करना होगा। गलत पूर्णताएँ एक भाषा मॉडल से नमूनाकरण और क्लासिफायर के एक सेट के साथ फ़िल्टर करके उत्पन्न की गईं। परिणामी समस्याएं मनुष्यों के लिए मामूली हैं, लेकिन जिस समय डेटासेट बनाए गए थे, उस समय अत्याधुनिक भाषा मॉडल में उनकी सटीकता कम थी। उदाहरण के लिए:

हमें एक फिटनेस सेंटर का चिन्ह दिखाई देता है। फिर हम एक आदमी को कैमरे से बात करते और व्यायाम गेंद पर बैठे और लेटे हुए देखते हैं। मनुष्य...

क) दर्शाता है कि गेंदों को ऊपर और नीचे चलाकर कुशल व्यायाम कार्य को कैसे बढ़ाया जाए।

ख) अपने सभी हाथ और पैर हिलाता है और बहुत सारी मांसपेशियाँ बनाता है।

ग) फिर गेंद खेलता है और हम एक ग्राफिक्स और हेज ट्रिमिंग प्रदर्शन देखते हैं।

घ) गेंद पर और बात करते समय उठक-बैठक करता है। [109]

बीईआरटी सबसे संभावित समापन के रूप में (बी) का चयन करता है, हालांकि सही उत्तर (डी) है। [109]

व्यापक प्रभाव[संपादित करें]

2023 में, नेचर बायोमेडिकल इंजीनियरिंग ने लिखा था कि बड़े भाषा मॉडल द्वारा बनाए गए पाठ से मानव-लिखित पाठ को "सटीक रूप से अलग करना अब संभव नहीं है", और यह कि "यह लगभग निश्चित है कि सामान्य-उद्देश्य वाले बड़े भाषा मॉडल तेजी से फैलेंगे... यह एक सुरक्षित शर्त है कि वे समय के साथ कई उद्योगों को बदल देंगे।" [110] गोल्डमैन सैक्स ने 2023 में सुझाव दिया था कि जेनेरेटिव भाषा एआई अगले दस वर्षों में वैश्विक सकल घरेलू उत्पाद में 7% की वृद्धि कर सकती है, और वैश्विक स्तर पर स्वचालन के कारण 300 मिलियन नौकरियां पैदा हो सकती हैं। [111] [112] कुछ टिप्पणीकारों ने आकस्मिक या जानबूझकर गलत सूचना के निर्माण, या अन्य प्रकार के दुरुपयोग पर चिंता व्यक्त की। [113] उदाहरण के लिए, बड़े भाषा मॉडल की उपलब्धता जैव-आतंकवाद को अंजाम देने के लिए आवश्यक कौशल-स्तर को कम कर सकती है; जैव सुरक्षा शोधकर्ता केविन एस्वेल्ट ने सुझाव दिया है कि एलएलएम रचनाकारों को रोगजनकों को बनाने या बढ़ाने पर अपने प्रशिक्षण डेटा पेपर से बाहर रखना चाहिए। [114]

सूची[संपादित करें]

| नाम | रिलीज़ की तारीख[a] | विकासक | मापदण्डों की संख्या[b] | कॉर्पस का आकार | प्रशिक्षण का ख़र्च (petaFLOP-day) | License[c] | Notes |

|---|---|---|---|---|---|---|---|

| BERT | 2018 | 340 million[115] | 3.3 billion words[115] | 9[116] | Apache 2.0[117] | An early and influential language model,[4] but encoder-only and thus not built to be prompted or generative[118] | |

| XLNet | 2019 | ~340 million[119] | 33 billion words | An alternative to BERT; designed as encoder-only[120][121] | |||

| GPT-2 | 2019 | OpenAI | 1.5 billion[122] | 40GB[123] (~10 billion tokens)[124] | 17[125] | MIT[126] | general-purpose model based on transformer architecture |

| GPT-3 | 2020 | OpenAI | 175 billion[45] | 300 billion tokens[124] | 3640[127] | साँचा:Partial success | A fine-tuned variant of GPT-3, termed GPT-3.5, was made available to the public through a web interface called ChatGPT in 2022.[128] |

| GPT-Neo | एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर।एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर। | EleutherAI | 2.7 billion[129] | 825 GiB[130] | 90[125] | MIT[131] | The first of a series of free GPT-3 alternatives released by EleutherAI. GPT-Neo outperformed an equivalent-size GPT-3 model on some benchmarks, but was significantly worse than the largest GPT-3.[131] |

| GPT-J | एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर।एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर। | EleutherAI | 6 billion[132] | 825 GiB[130] | 200[133] | Apache 2.0 | GPT-3-style language model |

| Megatron-Turing NLG | एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर।एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर।[134] | Microsoft and Nvidia | 530 billion[135] | 338.6 billion tokens[135] | 16000[125] | Restricted web access | Standard architecture but trained on a supercomputing cluster. |

| Ernie 3.0 Titan | एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर।एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर। | Baidu | 260 billion[136] | 4 Tb | Proprietary | Chinese-language LLM. Ernie Bot is based on this model. | |

| Claude[137] | एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर।एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर। | Anthropic | 52 billion[138] | 400 billion tokens[138] | साँचा:Partial success | Fine-tuned for desirable behavior in conversations.[139] | |

| GLaM (Generalist Language Model) | एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर।एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर। | 1.2 trillion[34] | 1.6 trillion tokens[34] | 5600[34] | Proprietary | Sparse mixture-of-experts model, making it more expensive to train but cheaper to run inference compared to GPT-3. | |

| Gopher | एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर।एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर। | DeepMind | 280 billion[140] | 300 billion tokens[141] | 5833[142] | Proprietary | |

| LaMDA (Language Models for Dialog Applications) | एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर।एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर। | 137 billion[143] | 1.56T words,[143] 168 billion tokens[141] | 4110[144] | Proprietary | Specialized for response generation in conversations. | |

| GPT-NeoX | एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर।एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर। | EleutherAI | 20 billion[145] | 825 GiB[130] | 740[133] | Apache 2.0 | based on the Megatron architecture |

| Chinchilla | एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर।एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर। | DeepMind | 70 billion[146] | 1.4 trillion tokens[146][141] | 6805[142] | Proprietary | Reduced-parameter model trained on more data. Used in the Sparrow bot. |

| PaLM (Pathways Language Model) | एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर।एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर। | 540 billion[147] | 768 billion tokens[146] | 29250[142] | Proprietary | aimed to reach the practical limits of model scale | |

| OPT (Open Pretrained Transformer) | एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर।एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर। | Meta | 175 billion[148] | 180 billion tokens[149] | 310[133] | साँचा:Partial success[d] | GPT-3 architecture with some adaptations from Megatron |

| YaLM 100B | एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर।एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर। | Yandex | 100 billion[150] | 1.7TB[150] | 2500[125] | Apache 2.0 | English-Russian model based on Microsoft's Megatron-LM. |

| Minerva | एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर।एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर। | 540 billion[151] | 38.5B tokens from webpages filtered for mathematical content and from papers submitted to the arXiv preprint server[151] | 32000[125] | Proprietary | LLM trained for solving "mathematical and scientific questions using step-by-step reasoning".[152] Minerva is based on PaLM model, further trained on mathematical and scientific data. | |

| BLOOM | एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर।एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर। | Large collaboration led by Hugging Face | 175 billion[153] | 350 billion tokens (1.6TB)[154] | 2100[125] | Responsible AI | Essentially GPT-3 but trained on a multi-lingual corpus (30% English excluding programming languages) |

| Galactica | एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर।एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर। | Meta | 120 billion | 106 billion tokens[155] | unknown | साँचा:Partial success | Trained on scientific text and modalities. |

| AlexaTM (Teacher Models) | एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर।एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर। | Amazon | 20 billion[156] | 1.3 trillion[157] | साँचा:Partial success[158] | bidirectional sequence-to-sequence architecture | |

| LLaMA (Large Language Model Meta AI) | एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर।एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर। | Meta | 65 billion[159] | 1.4 trillion[159] | 6300[160][125] | साँचा:Partial success[e] | Trained on a large 20-language corpus to aim for better performance with fewer parameters.[159] Researchers from Stanford University trained a fine-tuned model based on LLaMA weights, called Alpaca.[161] |

| GPT-4 | एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर।एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर। | OpenAI | Exact number unknown, approximately 1 trillion [f] | Unknown | 240000 (estimated)[125] | साँचा:Partial success | Available for ChatGPT Plus users and used in several products. |

| Cerebras-GPT | एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर।एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर। | Cerebras | 13 billion[163] | 270[133] | Apache 2.0 | Trained with Chinchilla formula. | |

| Falcon | एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर।एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर। | Technology Innovation Institute | 40 billion[164] | 1 trillion tokens, from RefinedWeb (filtered web text corpus)[165] plus some "curated corpora".[166] | 2800[160] | Apache 2.0[167] | Training cost around 2700 petaFLOP-days, 75% that of GPT-3. |

| BloombergGPT | एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर।एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर। | Bloomberg L.P. | 50 billion | 363 billion token dataset based on Bloomberg's data sources, plus 345 billion tokens from general purpose datasets[168] | Proprietary | LLM trained on financial data from proprietary sources, that "outperforms existing models on financial tasks by significant margins without sacrificing performance on general LLM benchmarks" | |

| PanGu-Σ | एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर।एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर। | Huawei | 1.085 trillion | 329 billion tokens[169] | Proprietary | ||

| OpenAssistant[170] | एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर।एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर। | LAION | 17 billion | 1.5 trillion tokens | Apache 2.0 | Trained on crowdsourced open data | |

| PaLM 2 (Pathways Language Model 2) | एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर।एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर। | 340 billion[171] | 3.6 trillion tokens[171] | 85000[160] | Proprietary | Used in Bard chatbot.[172] | |

| Llama 2 | एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर।एक्स्प्रेशन त्रुटि: अनपेक्षित < ऑपरेटर। | Meta | 70 billion[173] | 2 trillion tokens[173] | साँचा:Partial success | Successor of LLaMA. |

अग्रिम पठन[संपादित करें]

- Jurafsky, Dan, Martin, James. H. Speech and Language Processing: An Introduction to Natural Language Processing, Computational Linguistics, and Speech Recognition, 3rd Edition draft, 2023.

- Phuong, Mary; Hutter, Marcus (2022). "Formal Algorithms for Transformers". arXiv:2207.09238 [cs.LG].

- Eloundou, Tyna; Manning, Sam; Mishkin, Pamela; Rock, Daniel (2023). "GPTs are GPTs: An Early Look at the Labor Market Impact Potential of Large Language Models". arXiv:2303.10130 [econ.GN].

- Eldan, Ronen; Li, Yuanzhi (2023). "TinyStories: How Small Can Language Models Be and Still Speak Coherent English?". arXiv:2305.07759 [cs.CL].

- Frank, Michael C. (27 June 2023). "Baby steps in evaluating the capacities of large language models". Nature Reviews Psychology (अंग्रेज़ी में): 1–2. S2CID 259713140. आइ॰एस॰एस॰एन॰ 2731-0574. डीओआइ:10.1038/s44159-023-00211-x. अभिगमन तिथि 2 July 2023.

- Zhao, Wayne Xin; एवं अन्य (2023). "A Survey of Large Language Models". arXiv:2303.18223 [cs.CL].

- Kaddour, Jean; एवं अन्य (2023). "Challenges and Applications of Large Language Models". arXiv:2307.10169 [cs.CL].

टिप्पणियां[संपादित करें]

- ↑ यह वह तारीख है जब मॉडल की वास्तुकला का वर्णन करने वाला दस्तावेज़ पहली बार जारी किया गया था।

- ↑ कई मामलों में, शोधकर्ता अलग-अलग आकार वाले मॉडल के कई संस्करण जारी या रिपोर्ट करते हैं। इन मामलों में, सबसे बड़े मॉडल का आकार यहां सूचीबद्ध है।

- ↑ This is the license of the pre-trained model weights. In almost all cases the training code itself is open-source or can be easily replicated.

- ↑ The smaller models including 66B are publicly available, while the 175B model is available on request.

- ↑ Facebook's license and distribution scheme restricted access to approved researchers, but the model weights were leaked and became widely available.

- ↑ As stated in Technical report: "Given both the competitive landscape and the safety implications of large-scale models like GPT-4, this report contains no further details about the architecture (including model size), hardware, training compute, dataset construction, training method ..."[162] Approximate number in the comparison chart that compares the relative storage, from the same report.

संदर्भ[संपादित करें]

- ↑ Goled, Shraddha (May 7, 2021). "Self-Supervised Learning Vs Semi-Supervised Learning: How They Differ". Analytics India Magazine.Goled, Shraddha (May 7, 2021). "Self-Supervised Learning Vs Semi-Supervised Learning: How They Differ". Analytics India Magazine.

- ↑ अ आ Bowman, Samuel R. "Eight Things to Know about Large Language Models". arXiv:2304.00612 [cs.CL].Bowman, Samuel R. (2023). "Eight Things to Know about Large Language Models". arXiv:2304.00612 [cs.CL].

- ↑ "Better Language Models and Their Implications". OpenAI. 2019-02-14. मूल से 2020-12-19 को पुरालेखित. अभिगमन तिथि 2019-08-25."Better Language Models and Their Implications". OpenAI. 2019-02-14. Archived from the original on 2020-12-19. Retrieved 2019-08-25.

- ↑ अ आ इ ई उ ऊ Manning, Christopher D. (2022). "Human Language Understanding & Reasoning". Daedalus. 151 (2): 127–138. डीओआइ:10.1162/daed_a_01905.Manning, Christopher D. (2022). "Human Language Understanding & Reasoning". Daedalus. 151 (2): 127–138. doi:10.1162/daed_a_01905. S2CID 248377870.

- ↑ Chomsky, N. (September 1956). "Three models for the description of language". IRE Transactions on Information Theory. 2 (3): 113–124. आइ॰एस॰एस॰एन॰ 2168-2712. डीओआइ:10.1109/TIT.1956.1056813.Chomsky, N. (September 1956). "Three models for the description of language". IRE Transactions on Information Theory. 2 (3): 113–124. doi:10.1109/TIT.1956.1056813. ISSN 2168-2712. S2CID 19519474.

- ↑ Winograd, Terry (1972-01-01). "Understanding natural language". Cognitive Psychology (अंग्रेज़ी में). 3 (1): 1–191. आइ॰एस॰एस॰एन॰ 0010-0285. डीओआइ:10.1016/0010-0285(72)90002-3.Winograd, Terry (1972-01-01). "Understanding natural language". Cognitive Psychology. 3 (1): 1–191. doi:10.1016/0010-0285(72)90002-3. ISSN 0010-0285.

- ↑ Baker, C. L.; McCarthy, John J., संपा॰ (1981). The Logical Problem of Language Acquisition (English में). The MIT Press. आई॰ऍस॰बी॰ऍन॰ 978-0-262-52389-9.सीएस1 रखरखाव: नामालूम भाषा (link)Baker, C. L.; McCarthy, John J., eds. (1981). The Logical Problem of Language Acquisition. The MIT Press. ISBN 978-0-262-52389-9.

- ↑ Elman, Jeffrey L. (March 1990). "Finding Structure in Time". Cognitive Science (अंग्रेज़ी में). 14 (2): 179–211. डीओआइ:10.1207/s15516709cog1402_1.Elman, Jeffrey L. (March 1990). "Finding Structure in Time". Cognitive Science. 14 (2): 179–211. doi:10.1207/s15516709cog1402_1. S2CID 2763403.

- ↑ Shannon, C. E. (January 1951). "Prediction and Entropy of Printed English". Bell System Technical Journal. 30 (1): 50–64. आइ॰एस॰एस॰एन॰ 0005-8580. डीओआइ:10.1002/j.1538-7305.1951.tb01366.x.Shannon, C. E. (January 1951). "Prediction and Entropy of Printed English". Bell System Technical Journal. 30 (1): 50–64. doi:10.1002/j.1538-7305.1951.tb01366.x. ISSN 0005-8580.

- ↑ Miller, George A.; Chomsky, Noam (1963), Luce, D. (संपा॰), "Finitary Models of Language Users", Handbook of Mathematical Psychology, John Wiley & Sons., पपृ॰ 2–419, अभिगमन तिथि 2023-06-27Miller, George A.; Chomsky, Noam (1963), Luce, D. (ed.), "Finitary Models of Language Users", Handbook of Mathematical Psychology, John Wiley & Sons., pp. 2–419, retrieved 2023-06-27

- ↑ Brown, Peter F. (1993). "The mathematics of statistical machine translation: Parameter estimation". Computational Linguistics (19): 263–311.Brown, Peter F. (1993). "The mathematics of statistical machine translation: Parameter estimation". Computational Linguistics (19): 263–311.

- ↑ Gal, Yarin; Blunsom, Phil (12 June 2013). "A Systematic Bayesian Treatment of the IBM Alignment Models" (PDF). University of Cambridge. मूल से पुरालेखित 4 मार्च 2016. अभिगमन तिथि 26 October 2015.सीएस1 रखरखाव: BOT: original-url status unknown (link)Gal, Yarin; Blunsom, Phil (12 June 2013). (PDF). University of Cambridge. Archived from the original Archived 2016-03-04 at the वेबैक मशीन (PDF) on 4 Mar 2016. Retrieved 26 October 2015.

- ↑ Banko, Michele; Brill, Eric (2001). "Scaling to very very large corpora for natural language disambiguation". Proceedings of the 39th Annual Meeting on Association for Computational Linguistics - ACL '01. Morristown, NJ, USA: Association for Computational Linguistics: 26–33. डीओआइ:10.3115/1073012.1073017.Banko, Michele; Brill, Eric (2001). "Scaling to very very large corpora for natural language disambiguation". Proceedings of the 39th Annual Meeting on Association for Computational Linguistics - ACL '01. Morristown, NJ, USA: Association for Computational Linguistics: 26–33. doi:10.3115/1073012.1073017. S2CID 6645623.

- ↑ Sutskever, Ilya; Vinyals, Oriol; Le, Quoc V (2014). "Sequence to Sequence Learning with Neural Networks". Advances in Neural Information Processing Systems. Curran Associates, Inc. 27. arXiv:1409.3215.Sutskever, Ilya; Vinyals, Oriol; Le, Quoc V (2014). "Sequence to Sequence Learning with Neural Networks". Advances in Neural Information Processing Systems. Curran Associates, Inc. 27. arXiv:1409.3215.

- ↑ Cho, Kyunghyun; van Merrienboer, Bart; Bahdanau, Dzmitry; Bengio, Yoshua (2014). "On the Properties of Neural Machine Translation: Encoder–Decoder Approaches". Proceedings of SSST-8, Eighth Workshop on Syntax, Semantics and Structure in Statistical Translation. Stroudsburg, PA, USA: Association for Computational Linguistics: 103–111. डीओआइ:10.3115/v1/w14-4012.Cho, Kyunghyun; van Merrienboer, Bart; Bahdanau, Dzmitry; Bengio, Yoshua (2014). "On the Properties of Neural Machine Translation: Encoder–Decoder Approaches". Proceedings of SSST-8, Eighth Workshop on Syntax, Semantics and Structure in Statistical Translation. Stroudsburg, PA, USA: Association for Computational Linguistics: 103–111. doi:10.3115/v1/w14-4012. S2CID 11336213.

- ↑ अ आ Bahdanau, Dzmitry; Cho, Kyunghyun (2014-09-01). "Neural Machine Translation by Jointly Learning to Align and Translate". arXiv:1409.0473 [cs.CL].Bahdanau, Dzmitry; Cho, Kyunghyun; Bengio, Yoshua (2014-09-01). "Neural Machine Translation by Jointly Learning to Align and Translate". arXiv:1409.0473 [cs.CL].

- ↑ अ आ Vaswani, Ashish; Shazeer, Noam; Parmar, Niki; Uszkoreit, Jakob; Jones, Llion; Gomez, Aidan N; Kaiser, Łukasz; Polosukhin, Illia (2017). "Attention is All you Need". Advances in Neural Information Processing Systems. Curran Associates, Inc. 30.Vaswani, Ashish; Shazeer, Noam; Parmar, Niki; Uszkoreit, Jakob; Jones, Llion; Gomez, Aidan N; Kaiser, Łukasz; Polosukhin, Illia (2017). "Attention is All you Need". Advances in Neural Information Processing Systems. Curran Associates, Inc. 30.

- ↑ Lewis-Kraus, Gideon (2016-12-14). "The Great A.I. Awakening". The New York Times (अंग्रेज़ी में). आइ॰एस॰एस॰एन॰ 0362-4331. मूल से पुरालेखित 24 मई 2023. अभिगमन तिथि 2023-06-22.सीएस1 रखरखाव: BOT: original-url status unknown (link)Lewis-Kraus, Gideon (2016-12-14). . The New York Times. ISSN 0362-4331. Archived from the original on 24 May 2023. Retrieved 2023-06-22.

- ↑ Wu, Yonghui; Schuster, Mike (2016-09-01). "Google's Neural Machine Translation System: Bridging the Gap between Human and Machine Translation". arXiv:1609.08144 [cs.CL].Wu, Yonghui; et al. (2016-09-01). "Google's Neural Machine Translation System: Bridging the Gap between Human and Machine Translation". arXiv:1609.08144 [cs.CL].

- ↑ Devlin, Jacob; Chang, Ming-Wei (11 October 2018). "BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding". arXiv:1810.04805v2 [cs.CL].Devlin, Jacob; Chang, Ming-Wei; Lee, Kenton; Toutanova, Kristina (11 October 2018). "BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding". arXiv:1810.04805v2 [cs.CL].

- ↑ "Improving language understanding with unsupervised learning". openai.com (अंग्रेज़ी में). June 11, 2018. मूल से 2023-03-18 को पुरालेखित. अभिगमन तिथि 2023-03-18."Improving language understanding with unsupervised learning". openai.com. June 11, 2018. Archived from the original on 2023-03-18. Retrieved 2023-03-18.

- ↑ finetune-transformer-lm, OpenAI, June 11, 2018, अभिगमन तिथि 2023-05-01finetune-transformer-lm, OpenAI, June 11, 2018, retrieved 2023-05-01

- ↑ Sanh, Victor; Debut, Lysandre (2019-10-02). "DistilBERT, a distilled version of BERT: smaller, faster, cheaper and lighter?". arXiv:1910.01108 [cs.CL].Sanh, Victor; Debut, Lysandre; Chaumond, Julien; Wolf, Thomas (2019-10-02). "DistilBERT, a distilled version of BERT: smaller, faster, cheaper and lighter?". arXiv:1910.01108 [cs.CL].

- ↑ . Virtual Event, Canada.Emily M., Bender; Gebru, Timnit; McMillan-Major, Angelina; Mitchell, Margaret (2021-03-01). "On the Dangers of Stochastic Parrots: Can Language Models Be Too Big? 🦜". FAccT '21: Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency. FAccT '21. Virtual Event, Canada: ACM. pp. 610–623. doi:10.1145/3442188.3445922.

- ↑ A bot will complete this citation soon. Click here to jump the queue arXiv:1802.05365.Peters ME, Neumann M, Iyyer M, Gardner M, Clark C, Lee K, Zettlemoyer L (2018). "Deep contextualized word representations". arXiv:1802.05365 [cs.CL].

- ↑ Ganguli, Deep; Hernandez, Danny (2022-06-20). "2022 ACM Conference on Fairness, Accountability, and Transparency". ACM. pp. 1747–1764. doi:10.1145/3531146.3533229.Ganguli, Deep; Hernandez, Danny; Lovitt, Liane; et al. (2022-06-20). "Predictability and Surprise in Large Generative Models". 2022 ACM Conference on Fairness, Accountability, and Transparency. New York, NY, USA: ACM. pp. 1747–1764. doi:10.1145/3531146.3533229. ISBN 9781450393522.

- ↑ Kaplan, Jared; McCandlish, Sam. "Scaling Laws for Neural Language Models". arXiv:2001.08361 [cs.LG].Kaplan, Jared; McCandlish, Sam; Henighan, Tom; et al. (2020). "Scaling Laws for Neural Language Models". arXiv:2001.08361 [cs.LG].

- ↑ Hoffmann, Jordan; Borgeaud, Sebastian. "Training Compute-Optimal Large Language Models". arXiv:2203.15556 [cs.CL].Hoffmann, Jordan; Borgeaud, Sebastian; Mensch, Arthur; et al. (2022). "Training Compute-Optimal Large Language Models". arXiv:2203.15556 [cs.CL].

- ↑ Chowdhery, Aakanksha; Narang, Sharan. "PaLM: Scaling Language Modeling with Pathways". arXiv:2204.02311 [cs.CL].Chowdhery, Aakanksha; Narang, Sharan; Devlin, Jacob; et al. (2022). "PaLM: Scaling Language Modeling with Pathways". arXiv:2204.02311 [cs.CL].

- ↑ Kjell (2019). "Semantic measures: Using natural language processing to measure, differentiate, and describe psychological constructs". Psychological Methods. 24 (1): 92–115. PMID 29963879. डीओआइ:10.1037/met0000191.Kjell (2019). "Semantic measures: Using natural language processing to measure, differentiate, and describe psychological constructs". Psychological Methods. 24 (1): 92–115. doi:10.1037/met0000191. PMID 29963879. S2CID 49642731.

- ↑ अ आ Schaeffer, Rylan; Miranda, Brando (2023-04-01). "Are Emergent Abilities of Large Language Models a Mirage?". arXiv:2304.15004 [cs.AI].Schaeffer, Rylan; Miranda, Brando; Koyejo, Sanmi (2023-04-01). "Are Emergent Abilities of Large Language Models a Mirage?". arXiv:2304.15004 [cs.AI].

- ↑ Shazeer, Noam; Mirhoseini, Azalia (2017-01-01). "Outrageously Large Neural Networks: The Sparsely-Gated Mixture-of-Experts Layer". arXiv:1701.06538 [cs.LG].Shazeer, Noam; Mirhoseini, Azalia; Maziarz, Krzysztof; Davis, Andy; Le, Quoc; Hinton, Geoffrey; Dean, Jeff (2017-01-01). "Outrageously Large Neural Networks: The Sparsely-Gated Mixture-of-Experts Layer". arXiv:1701.06538 [cs.LG].

- ↑ Lepikhin, Dmitry; Lee, HyoukJoong (2021-01-12). "GShard: Scaling Giant Models with Conditional Computation and Automatic Sharding" (अंग्रेज़ी में). arXiv:2006.16668 [cs.CL].Lepikhin, Dmitry; Lee, HyoukJoong; Xu, Yuanzhong; Chen, Dehao; Firat, Orhan; Huang, Yanping; Krikun, Maxim; Shazeer, Noam; Chen, Zhifeng (2021-01-12). "GShard: Scaling Giant Models with Conditional Computation and Automatic Sharding". arXiv:2006.16668 [cs.CL].

- ↑ अ आ इ ई सन्दर्भ त्रुटि:

<ref>का गलत प्रयोग;glam-blogनाम के संदर्भ में जानकारी नहीं है। - ↑ "OpenAI API". platform.openai.com (अंग्रेज़ी में). मूल से पुरालेखित 23 अप्रैल 2023. अभिगमन तिथि 2023-04-30.सीएस1 रखरखाव: BOT: original-url status unknown (link). platform.openai.com. Archived from the original on April 23, 2023. Retrieved 2023-04-30.

- ↑ "OpenAI API". platform.openai.com (अंग्रेज़ी में). मूल से पुरालेखित 20 जून 2023. अभिगमन तिथि 2023-06-20.सीएस1 रखरखाव: BOT: original-url status unknown (link). platform.openai.com. Archived from the original on 16 Jun 2023. Retrieved 2023-06-20.

- ↑ Zaib, Munazza; Sheng, Quan Z.; Emma Zhang, Wei (4 February 2020). "A Short Survey of Pre-trained Language Models for Conversational AI-A New Age in NLP". Proceedings of the Australasian Computer Science Week Multiconference: 1–4. arXiv:2104.10810. आई॰ऍस॰बी॰ऍन॰ 9781450376976. डीओआइ:10.1145/3373017.3373028.Zaib, Munazza; Sheng, Quan Z.; Emma Zhang, Wei (4 February 2020). "A Short Survey of Pre-trained Language Models for Conversational AI-A New Age in NLP". Proceedings of the Australasian Computer Science Week Multiconference: 1–4. arXiv:2104.10810. doi:10.1145/3373017.3373028. ISBN 9781450376976. S2CID 211040895.

- ↑ अ आ इ ई उ ऊ Jurafsky, Dan; Martin, James H. (7 January 2023). Speech and Language Processing (PDF) (3rd edition draft संस्करण). अभिगमन तिथि 24 May 2022.

- ↑ Zhu, Yukun; Kiros, Ryan; Zemel, Rich; Salakhutdinov, Ruslan; Urtasun, Raquel; Torralba, Antonio; Fidler, Sanja (December 2015). "Aligning Books and Movies: Towards Story-Like Visual Explanations by Watching Movies and Reading Books" (PDF). 2015 IEEE International Conference on Computer Vision (ICCV). 2015 IEEE International Conference on Computer Vision (ICCV). पपृ॰ 19–27. arXiv:1506.06724. आई॰ऍस॰बी॰ऍन॰ 978-1-4673-8391-2. डीओआइ:10.1109/ICCV.2015.11. अभिगमन तिथि 11 April 2023.Zhu, Yukun; Kiros, Ryan; Zemel, Rich; Salakhutdinov, Ruslan; Urtasun, Raquel; Torralba, Antonio; Fidler, Sanja (December 2015). "Aligning Books and Movies: Towards Story-Like Visual Explanations by Watching Movies and Reading Books" (PDF). 2015 IEEE International Conference on Computer Vision (ICCV). 2015 IEEE International Conference on Computer Vision (ICCV). pp. 19–27. arXiv:1506.06724. doi:10.1109/ICCV.2015.11. ISBN 978-1-4673-8391-2. S2CID 6866988. Retrieved 11 April 2023.

- ↑ Nagel, Markus; Amjad, Rana Ali; Baalen, Mart Van; Louizos, Christos; Blankevoort, Tijmen (2020-11-21). "Up or Down? Adaptive Rounding for Post-Training Quantization". Proceedings of the 37th International Conference on Machine Learning (अंग्रेज़ी में). PMLR: 7197–7206.Nagel, Markus; Amjad, Rana Ali; Baalen, Mart Van; Louizos, Christos; Blankevoort, Tijmen (2020-11-21). "Up or Down? Adaptive Rounding for Post-Training Quantization". Proceedings of the 37th International Conference on Machine Learning. PMLR: 7197–7206.

- ↑ Polino, Antonio; Pascanu, Razvan (2018-02-01). "Model compression via distillation and quantization". arXiv:1802.05668 [cs.NE].Polino, Antonio; Pascanu, Razvan; Alistarh, Dan (2018-02-01). "Model compression via distillation and quantization". arXiv:1802.05668 [cs.NE].

- ↑ Frantar, Elias; Ashkboos, Saleh (2022-10-01). "GPTQ: Accurate Post-Training Quantization for Generative Pre-trained Transformers". arXiv:2210.17323 [cs.LG].Frantar, Elias; Ashkboos, Saleh; Hoefler, Torsten; Alistarh, Dan (2022-10-01). "GPTQ: Accurate Post-Training Quantization for Generative Pre-trained Transformers". arXiv:2210.17323 [cs.LG].

- ↑ Dettmers, Tim; Svirschevski, Ruslan (2023-06-01). "SpQR: A Sparse-Quantized Representation for Near-Lossless LLM Weight Compression". arXiv:2306.03078 [cs.CL].Dettmers, Tim; Svirschevski, Ruslan; Egiazarian, Vage; Kuznedelev, Denis; Frantar, Elias; Ashkboos, Saleh; Borzunov, Alexander; Hoefler, Torsten; Alistarh, Dan (2023-06-01). "SpQR: A Sparse-Quantized Representation for Near-Lossless LLM Weight Compression". arXiv:2306.03078 [cs.CL].

- ↑ Dettmers, Tim; Pagnoni, Artidoro (2023-05-01). "QLoRA: Efficient Finetuning of Quantized LLMs". arXiv:2305.14314 [cs.LG].Dettmers, Tim; Pagnoni, Artidoro; Holtzman, Ari; Zettlemoyer, Luke (2023-05-01). "QLoRA: Efficient Finetuning of Quantized LLMs". arXiv:2305.14314 [cs.LG].

- ↑ अ आ इ Wiggers, Kyle (28 April 2022). "The emerging types of language models and why they matter". TechCrunch.Wiggers, Kyle (28 April 2022). "The emerging types of language models and why they matter". TechCrunch.

- ↑ Sharir, Or; Peleg, Barak. "The Cost of Training NLP Models: A Concise Overview". arXiv:2004.08900 [cs.CL].Sharir, Or; Peleg, Barak; Shoham, Yoav (2020). "The Cost of Training NLP Models: A Concise Overview". arXiv:2004.08900 [cs.CL].

- ↑ Biderman, Stella; Schoelkopf, Hailey (April 2023). "Pythia: A Suite for Analyzing Large Language Models Across Training and Scaling". arXiv:2304.01373 [cs.CL].Biderman, Stella; Schoelkopf, Hailey; Anthony, Quentin; Bradley, Herbie; Khan, Mohammad Aflah; Purohit, Shivanshu; Prashanth, USVSN Sai (April 2023). "Pythia: A Suite for Analyzing Large Language Models Across Training and Scaling". arXiv:2304.01373 [cs.CL].

- ↑ Vincent, James (3 April 2023). "AI is entering an era of corporate control". The Verge. अभिगमन तिथि 19 June 2023.Vincent, James (3 April 2023). "AI is entering an era of corporate control". The Verge. Retrieved 19 June 2023.

- ↑ अ आ Kaplan, Jared; McCandlish, Sam. "Scaling Laws for Neural Language Models". arXiv:2001.08361 [cs.LG].Kaplan, Jared; McCandlish, Sam; Henighan, Tom; Brown, Tom B.; Chess, Benjamin; Child, Rewon; Gray, Scott; Radford, Alec; Wu, Jeffrey; Amodei, Dario (2020). "Scaling Laws for Neural Language Models". arXiv:2001.08361 [cs.LG].

- ↑ अ आ इ ई Brown, Tom B.; Mann, Benjamin; Ryder, Nick; Subbiah, Melanie; Kaplan, Jared; Dhariwal, Prafulla; Neelakantan, Arvind; Shyam, Pranav; Sastry, Girish (Dec 2020). Larochelle, H.; Ranzato, M.; Hadsell, R.; Balcan, M.F.; Lin, H. (संपा॰). "Language Models are Few-Shot Learners" (PDF). Advances in Neural Information Processing Systems. Curran Associates, Inc. 33: 1877–1901.Brown, Tom B.; Mann, Benjamin; Ryder, Nick; Subbiah, Melanie; Kaplan, Jared; Dhariwal, Prafulla; Neelakantan, Arvind; Shyam, Pranav; Sastry, Girish; Askell, Amanda; Agarwal, Sandhini; Herbert-Voss, Ariel; Krueger, Gretchen; Henighan, Tom; Child, Rewon; Ramesh, Aditya; Ziegler, Daniel M.; Wu, Jeffrey; Winter, Clemens; Hesse, Christopher; Chen, Mark; Sigler, Eric; Litwin, Mateusz; Gray, Scott; Chess, Benjamin; Clark, Jack; Berner, Christopher; McCandlish, Sam; Radford, Alec; Sutskever, Ilya; Amodei, Dario (Dec 2020). Larochelle, H.; Ranzato, M.; Hadsell, R.; Balcan, M.F.; Lin, H. (eds.). "Language Models are Few-Shot Learners" (PDF). Advances in Neural Information Processing Systems. Curran Associates, Inc. 33: 1877–1901.

- ↑ अ आ इ ई Wei, Jason; Tay, Yi; Bommasani, Rishi; Raffel, Colin; Zoph, Barret; Borgeaud, Sebastian; Yogatama, Dani; Bosma, Maarten; Zhou, Denny (31 August 2022). "Emergent Abilities of Large Language Models". Transactions on Machine Learning Research (अंग्रेज़ी में). आइ॰एस॰एस॰एन॰ 2835-8856.Wei, Jason; Tay, Yi; Bommasani, Rishi; Raffel, Colin; Zoph, Barret; Borgeaud, Sebastian; Yogatama, Dani; Bosma, Maarten; Zhou, Denny; Metzler, Donald; Chi, Ed H.; Hashimoto, Tatsunori; Vinyals, Oriol; Liang, Percy; Dean, Jeff; Fedus, William (31 August 2022). "Emergent Abilities of Large Language Models". Transactions on Machine Learning Research. ISSN 2835-8856.

- ↑ Wang, Yizhong; Kordi, Yeganeh (2022). "Self-Instruct: Aligning Language Model with Self Generated Instructions". arXiv:2212.10560 [cs.CL].Wang, Yizhong; Kordi, Yeganeh; Mishra, Swaroop; Liu, Alisa; Smith, Noah A.; Khashabi, Daniel; Hajishirzi, Hannaneh (2022). "Self-Instruct: Aligning Language Model with Self Generated Instructions". arXiv:2212.10560 [cs.CL].

- ↑ Ouyang, Long; Wu, Jeff (2022). "Training language models to follow instructions with human feedback". arXiv:2203.02155 [cs.CL].Ouyang, Long; Wu, Jeff; Jiang, Xu; Almeida, Diogo; Wainwright, Carroll L.; Mishkin, Pamela; Zhang, Chong; Agarwal, Sandhini; Slama, Katarina; Ray, Alex; Schulman, John; Hilton, Jacob; Kelton, Fraser; Miller, Luke; Simens, Maddie; Askell, Amanda; Welinder, Peter; Christiano, Paul; Leike, Jan; Lowe, Ryan (2022). "Training language models to follow instructions with human feedback". arXiv:2203.02155 [cs.CL].

- ↑ Gao, Luyu; Madaan, Aman (2022-11-01). "PAL: Program-aided Language Models". arXiv:2211.10435 [cs.CL].Gao, Luyu; Madaan, Aman; Zhou, Shuyan; Alon, Uri; Liu, Pengfei; Yang, Yiming; Callan, Jamie; Neubig, Graham (2022-11-01). "PAL: Program-aided Language Models". arXiv:2211.10435 [cs.CL].

- ↑ "PAL: Program-aided Language Models". reasonwithpal.com. अभिगमन तिथि 2023-06-12."PAL: Program-aided Language Models". reasonwithpal.com. Retrieved 2023-06-12.

- ↑ Paranjape, Bhargavi; Lundberg, Scott (2023-03-01). "ART: Automatic multi-step reasoning and tool-use for large language models". arXiv:2303.09014 [cs.CL].Paranjape, Bhargavi; Lundberg, Scott; Singh, Sameer; Hajishirzi, Hannaneh; Zettlemoyer, Luke; Tulio Ribeiro, Marco (2023-03-01). "ART: Automatic multi-step reasoning and tool-use for large language models". arXiv:2303.09014 [cs.CL].

- ↑ Liang, Yaobo; Wu, Chenfei (2023-03-01). "TaskMatrix.AI: Completing Tasks by Connecting Foundation Models with Millions of APIs". arXiv:2303.16434 [cs.AI].Liang, Yaobo; Wu, Chenfei; Song, Ting; Wu, Wenshan; Xia, Yan; Liu, Yu; Ou, Yang; Lu, Shuai; Ji, Lei; Mao, Shaoguang; Wang, Yun; Shou, Linjun; Gong, Ming; Duan, Nan (2023-03-01). "TaskMatrix.AI: Completing Tasks by Connecting Foundation Models with Millions of APIs". arXiv:2303.16434 [cs.AI].

- ↑ Patil, Shishir G.; Zhang, Tianjun (2023-05-01). "Gorilla: Large Language Model Connected with Massive APIs". arXiv:2305.15334 [cs.CL].Patil, Shishir G.; Zhang, Tianjun; Wang, Xin; Gonzalez, Joseph E. (2023-05-01). "Gorilla: Large Language Model Connected with Massive APIs". arXiv:2305.15334 [cs.CL].

- ↑ Lewis, Patrick; Perez, Ethan; Piktus, Aleksandra; Petroni, Fabio; Karpukhin, Vladimir; Goyal, Naman; Küttler, Heinrich; Lewis, Mike; Yih, Wen-tau (2020). "Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks". Advances in Neural Information Processing Systems. Curran Associates, Inc. 33: 9459–9474. arXiv:2005.11401.Lewis, Patrick; Perez, Ethan; Piktus, Aleksandra; Petroni, Fabio; Karpukhin, Vladimir; Goyal, Naman; Küttler, Heinrich; Lewis, Mike; Yih, Wen-tau; Rocktäschel, Tim; Riedel, Sebastian; Kiela, Douwe (2020). "Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks". Advances in Neural Information Processing Systems. Curran Associates, Inc. 33: 9459–9474. arXiv:2005.11401.

- ↑ Huang, Wenlong; Abbeel, Pieter; Pathak, Deepak; Mordatch, Igor (2022-06-28). "Language Models as Zero-Shot Planners: Extracting Actionable Knowledge for Embodied Agents". Proceedings of the 39th International Conference on Machine Learning (अंग्रेज़ी में). PMLR: 9118–9147. arXiv:2201.07207.Huang, Wenlong; Abbeel, Pieter; Pathak, Deepak; Mordatch, Igor (2022-06-28). "Language Models as Zero-Shot Planners: Extracting Actionable Knowledge for Embodied Agents". Proceedings of the 39th International Conference on Machine Learning. PMLR: 9118–9147. arXiv:2201.07207.

- ↑ Yao, Shunyu; Zhao, Jeffrey (2022-10-01). "ReAct: Synergizing Reasoning and Acting in Language Models". arXiv:2210.03629 [cs.CL].Yao, Shunyu; Zhao, Jeffrey; Yu, Dian; Du, Nan; Shafran, Izhak; Narasimhan, Karthik; Cao, Yuan (2022-10-01). "ReAct: Synergizing Reasoning and Acting in Language Models". arXiv:2210.03629 [cs.CL].

- ↑ Wu, Yue; Prabhumoye, Shrimai (24 May 2023). "SPRING: GPT-4 Out-performs RL Algorithms by Studying Papers and Reasoning". arXiv:2305.15486 [cs.AI].Wu, Yue; Prabhumoye, Shrimai; Min, So Yeon (24 May 2023). "SPRING: GPT-4 Out-performs RL Algorithms by Studying Papers and Reasoning". arXiv:2305.15486 [cs.AI].

- ↑ Shinn, Noah; Cassano, Federico (2023-03-01). "Reflexion: Language Agents with Verbal Reinforcement Learning". arXiv:2303.11366 [cs.AI].Shinn, Noah; Cassano, Federico; Labash, Beck; Gopinath, Ashwin; Narasimhan, Karthik; Yao, Shunyu (2023-03-01). "Reflexion: Language Agents with Verbal Reinforcement Learning". arXiv:2303.11366 [cs.AI].

- ↑ Hao, Shibo; Gu, Yi (2023-05-01). "Reasoning with Language Model is Planning with World Model". arXiv:2305.14992 [cs.CL].Hao, Shibo; Gu, Yi; Ma, Haodi; Jiahua Hong, Joshua; Wang, Zhen; Zhe Wang, Daisy; Hu, Zhiting (2023-05-01). "Reasoning with Language Model is Planning with World Model". arXiv:2305.14992 [cs.CL].

- ↑ Zhang, Jenny; Lehman, Joel (2 June 2023). "OMNI: Open-endedness via Models of human Notions of Interestingness". arXiv:2306.01711 [cs.AI].Zhang, Jenny; Lehman, Joel; Stanley, Kenneth; Clune, Jeff (2 June 2023). "OMNI: Open-endedness via Models of human Notions of Interestingness". arXiv:2306.01711 [cs.AI].

- ↑ अ आ "Voyager | An Open-Ended Embodied Agent with Large Language Models". voyager.minedojo.org. अभिगमन तिथि 2023-06-09."Voyager | An Open-Ended Embodied Agent with Large Language Models". voyager.minedojo.org. Retrieved 2023-06-09.

- ↑ Park, Joon Sung; O'Brien, Joseph C. (2023-04-01). "Generative Agents: Interactive Simulacra of Human Behavior". arXiv:2304.03442 [cs.HC].Park, Joon Sung; O'Brien, Joseph C.; Cai, Carrie J.; Ringel Morris, Meredith; Liang, Percy; Bernstein, Michael S. (2023-04-01). "Generative Agents: Interactive Simulacra of Human Behavior". arXiv:2304.03442 [cs.HC].

- ↑ Kiros, Ryan; Salakhutdinov, Ruslan; Zemel, Rich (2014-06-18). "Multimodal Neural Language Models". Proceedings of the 31st International Conference on Machine Learning (अंग्रेज़ी में). PMLR: 595–603.Kiros, Ryan; Salakhutdinov, Ruslan; Zemel, Rich (2014-06-18). "Multimodal Neural Language Models". Proceedings of the 31st International Conference on Machine Learning. PMLR: 595–603.

- ↑ Krizhevsky, Alex; Sutskever, Ilya; Hinton, Geoffrey E (2012). "ImageNet Classification with Deep Convolutional Neural Networks". Advances in Neural Information Processing Systems. Curran Associates, Inc. 25.

- ↑ Antol, Stanislaw; Agrawal, Aishwarya; Lu, Jiasen; Mitchell, Margaret; Batra, Dhruv; Zitnick, C. Lawrence; Parikh, Devi (2015). "VQA: Visual Question Answering": 2425–2433. Cite journal requires

|journal=(मदद) - ↑ Yin, Shukang; Fu, Chaoyou (2023-06-01). "A Survey on Multimodal Large Language Models". arXiv:2306.13549 [cs.CV].Yin, Shukang; Fu, Chaoyou; Zhao, Sirui; Li, Ke; Sun, Xing; Xu, Tong; Chen, Enhong (2023-06-01). "A Survey on Multimodal Large Language Models". arXiv:2306.13549 [cs.CV].

- ↑ Li, Junnan; Li, Dongxu (2023-01-01). "BLIP-2: Bootstrapping Language-Image Pre-training with Frozen Image Encoders and Large Language Models". arXiv:2301.12597 [cs.CV].Li, Junnan; Li, Dongxu; Savarese, Silvio; Hoi, Steven (2023-01-01). "BLIP-2: Bootstrapping Language-Image Pre-training with Frozen Image Encoders and Large Language Models". arXiv:2301.12597 [cs.CV].

- ↑ Alayrac, Jean-Baptiste; Donahue, Jeff; Luc, Pauline; Miech, Antoine; Barr, Iain; Hasson, Yana; Lenc, Karel; Mensch, Arthur; Millican, Katherine (2022-12-06). "Flamingo: a Visual Language Model for Few-Shot Learning". Advances in Neural Information Processing Systems (अंग्रेज़ी में). 35: 23716–23736. arXiv:2204.14198.Alayrac, Jean-Baptiste; Donahue, Jeff; Luc, Pauline; Miech, Antoine; Barr, Iain; Hasson, Yana; Lenc, Karel; Mensch, Arthur; Millican, Katherine; Reynolds, Malcolm; Ring, Roman; Rutherford, Eliza; Cabi, Serkan; Han, Tengda; Gong, Zhitao (2022-12-06). "Flamingo: a Visual Language Model for Few-Shot Learning". Advances in Neural Information Processing Systems. 35: 23716–23736. arXiv:2204.14198.

- ↑ Driess, Danny; Xia, Fei (2023-03-01). "PaLM-E: An Embodied Multimodal Language Model". arXiv:2303.03378 [cs.LG].Driess, Danny; Xia, Fei; Sajjadi, Mehdi S. M.; Lynch, Corey; Chowdhery, Aakanksha; Ichter, Brian; Wahid, Ayzaan; Tompson, Jonathan; Vuong, Quan; Yu, Tianhe; Huang, Wenlong; Chebotar, Yevgen; Sermanet, Pierre; Duckworth, Daniel; Levine, Sergey (2023-03-01). "PaLM-E: An Embodied Multimodal Language Model". arXiv:2303.03378 [cs.LG].

- ↑ Liu, Haotian; Li, Chunyuan (2023-04-01). "Visual Instruction Tuning". arXiv:2304.08485 [cs.CV].Liu, Haotian; Li, Chunyuan; Wu, Qingyang; Lee, Yong Jae (2023-04-01). "Visual Instruction Tuning". arXiv:2304.08485 [cs.CV].

- ↑ Zhang, Hang; Li, Xin (2023-06-01). "Video-LLaMA: An Instruction-tuned Audio-Visual Language Model for Video Understanding". arXiv:2306.02858 [cs.CL].Zhang, Hang; Li, Xin; Bing, Lidong (2023-06-01). "Video-LLaMA: An Instruction-tuned Audio-Visual Language Model for Video Understanding". arXiv:2306.02858 [cs.CL].

- ↑ OpenAI (2023-03-27). "GPT-4 Technical Report". arXiv:2303.08774 [cs.CL].OpenAI (2023-03-27). "GPT-4 Technical Report". arXiv:2303.08774 [cs.CL].

- ↑ Pichai, Sundar, Google Keynote (Google I/O '23) (अंग्रेज़ी में), timestamp 15:31, अभिगमन तिथि 2023-07-02Pichai, Sundar, Google Keynote (Google I/O '23), timestamp 15:31, retrieved 2023-07-02

- ↑ Anil, Rohan; Dai, Andrew M. "PaLM 2 Technical Report". arXiv:2305.10403 [cs.CL].Anil, Rohan; et al. (2023). "PaLM 2 Technical Report". arXiv:2305.10403 [cs.CL].

- ↑ "Papers with Code - MassiveText Dataset". paperswithcode.com (अंग्रेज़ी में). अभिगमन तिथि 2023-04-26."Papers with Code - MassiveText Dataset". paperswithcode.com. Retrieved 2023-04-26.

- ↑ Wu, Shijie; Irsoy, Ozan. "BloombergGPT: A Large Language Model for Finance". arXiv:2303.17564 [cs.LG].Wu, Shijie; Irsoy, Ozan; Lu, Steven; Dabravolski, Vadim; Dredze, Mark; Gehrmann, Sebastian; Kambadur, Prabhanjan; Rosenberg, David; Mann, Gideon (2023). "BloombergGPT: A Large Language Model for Finance". arXiv:2303.17564 [cs.LG].

- ↑ Dodge, Jesse; Sap, Maarten. "Documenting Large Webtext Corpora: A Case Study on the Colossal Clean Crawled Corpus". arXiv:2104.08758 [cs.CL].Dodge, Jesse; Sap, Maarten; Marasović, Ana; Agnew, William; Ilharco, Gabriel; Groeneveld, Dirk; Mitchell, Margaret; Gardner, Matt (2021). "Documenting Large Webtext Corpora: A Case Study on the Colossal Clean Crawled Corpus". arXiv:2104.08758 [cs.CL].

- ↑ Villalobos, Pablo; Sevilla, Jaime (2022-10-25). "Will we run out of data? An analysis of the limits of scaling datasets in Machine Learning". arXiv:2211.04325 [cs.LG].Villalobos, Pablo; Sevilla, Jaime; Heim, Lennart; Besiroglu, Tamay; Hobbhahn, Marius; Ho, Anson (2022-10-25). "Will we run out of data? An analysis of the limits of scaling datasets in Machine Learning". arXiv:2211.04325 [cs.LG].